La visión de la startup: micromovilidad más inteligente a través de la IA 🛴

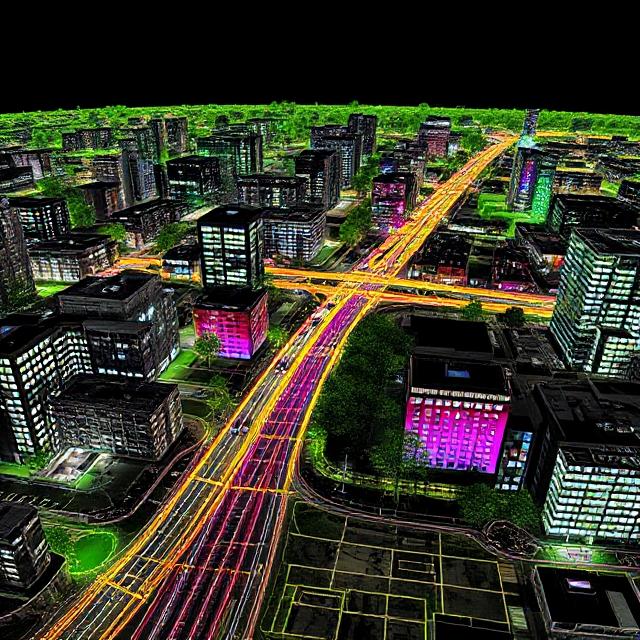

El cliente, una empresa emergente respaldada por empresas con sede en el norte de Europa, tenía una misión audaz: rediseñar el transporte de última milla con soluciones de micromovilidad impulsadas por inteligencia artificial. Piense en patinetes eléctricos, robots autónomos para aceras y vehículos de reparto compactos que puedan entender su entorno y tomar decisiones en tiempo real.

Para hacer realidad esta visión, necesitaban algo más que un vehículo: necesitaban percepción. Y eso requería datos sólidos:

- Nubes de puntos LiDAR anotadas

- Imágenes de cámara sincronizadas

- Marcas de tiempo GPS precisas

- Etiquetas semánticas ricas

Conjuntos de datos estándar como KITTI o Escenas nuestas eran demasiado generalizados. No reflejaban la densidad, los obstáculos o la fluctuación del GPS típicos de los centros urbanos históricos con adoquines, callejones estrechos y desorden peatonal. La startup necesitaba algo personalizado.

Alcance y limitaciones del proyecto: equilibrar la ambición con la realidad 🧭

La solicitud inicial era ambiciosa:

- Fusiona escaneos LiDAR 3D con datos de cámaras estéreo delanteras/traseras y registros IMU/GPS

- Anota objetos en movimiento (coches, bicicletas, peatones) e infraestructuras estáticas (bordillos, señales de tráfico, postes)

- Proporcione segmentación panóptica para zonas críticas como aceras y carriles para bicicletas

- Entregue 200 escenas de 5 ciudades en 3 meses

🔍 Pero esta es la realidad:

- Tamaño de datos por escena: entre 2 y 4 GB sin comprimir

- Complejidad de fusión: La alineación de los fotogramas necesitaba una sincronización temporal precisa

- Deriva LiDAR en calles estrechas era un problema recurrente

- Sensores múltiples crearon desalineaciones que requerían una calibración constante

Para mantenerse dentro del presupuesto y el tiempo, el alcance evolucionó a mitad del proyecto, una decisión que, en última instancia, evitó que el cliente se agotara y desperdiciara recursos. Vamos a explicar cómo hacerlo.

Desde la captura sin procesar hasta los datos listos para la fusión: configuración de Pipeline 🔧

A primera vista, recopilar datos de los sensores puede parecer una tarea sencilla: conducir el vehículo, recopilar las grabaciones y enviar los archivos al equipo de etiquetado. Pero, en realidad, transformar la entrada sin procesar de varios sensores en conjunto de datos listo para la fusión y fácil de anotar es un proceso técnicamente exigente que abarca el hardware, el software y la ingeniería de datos.

La startup de movilidad urbana se dio cuenta rápidamente de que Fusion Pipeline en sí sería el eje de todo el proyecto. Sin una canalización bien estructurada, incluso los mejores anotadores se verían ralentizados por las incoherencias, la falta de marcos y los errores de sincronización.

Así es como el equipo abordó el desafío de la fusión, paso a paso.

Configuración de hardware multisensor: el vehículo de captura

Para percibir con precisión el entorno urbano, el vehículo estaba equipado con un equipo de sensores personalizado que recopilaba datos en tiempo real. Los componentes clave incluían:

- Sensor LiDAR (Velodyne VLP-32C): Capturó nubes de puntos de 360° de alta resolución a 10 Hz, ideales para detectar geometría 3D en escenas urbanas.

- Cámaras RGB estéreo: Las cámaras frontales duales de 1080p proporcionaban contexto visual y ayudaban a la segmentación semántica, especialmente útil en zonas ocluidas o ambiguas.

- GPS con corrección RTK: Proporcionó una precisión de ubicación de nivel centimétrico, crucial en áreas urbanas densas con zonas de sombra GPS.

- Unidad de medición inercial (IMU): Inclinación, guiñada y aceleración grabadas para ayudar a fusionar los sensores y corregir la deriva del GPS.

- Módulo Data Logger + Edge Compute: Un sistema informático integrado compacto marcaba la hora, sincronizaba y almacenaba todos los datos entrantes con un ancho de banda elevado.

Esta configuración permitió que el scooter capturara información espacial y visual de alta fidelidad cada segundo, lo que genera aproximadamente de 2 a 4 GB de datos sin procesar por escena.

Sincronización y calibración de sensores

La sincronización no era opcional: incluso los pequeños desajustes en las marcas de tiempo entre el LiDAR y los marcos de la cámara podían distorsionar las superposiciones proyectadas y provocar errores de anotación y desalineación de la IA.

Para resolver esto, el equipo implementó:

- Coincidencia de marcas de tiempo de alta frecuencia a través de ROS (sistema operativo de robots)

- Calibración extrínseca uso de objetivos de tablero de ajedrez para la alineación de la cámara LIDAR

- Protocolos de sincronización horaria basado en PTP (Protocolo de tiempo de precisión)

- Recalibración dinámica procedimientos que se activan cada 2 o 3 días después de la captura para tener en cuenta la desviación del sensor debido a la vibración y los cambios de temperatura

Cada flujo de datos (LiDAR, imagen, GPS, IMU) se marcó de forma individual y, posteriormente, se fusionó mediante scripts de Python personalizados que alineaban los fotogramas por milisegundo.

Formato y almacenamiento de datos

Una vez calibrados y alineados con el tiempo, los datos se formatearon para su uso posterior:

- Nubes de puntos LiDAR se almacenaron en

.pcdy.binformatos, compatibles con herramientas de visualización como 3D abierto y PCL. - Imágenes se salvaron sin pérdidas

.pngpara conservar los detalles de los bordes para la anotación. - Metadatos combinados (incluida la pose, el encabezado y el índice del marco) se empaquetó en

.jsony.yamlarchivos por escena. - Segmentación de escenas las herramientas dividen las capturas largas en cortes de 30 segundos para lograr una anotación eficiente.

¿La salida? Un conjunto de datos listo para la fusión, preparado tanto para los anotadores como para los ingenieros de IA: limpio, sincronizado y rico desde el punto de vista semántico.

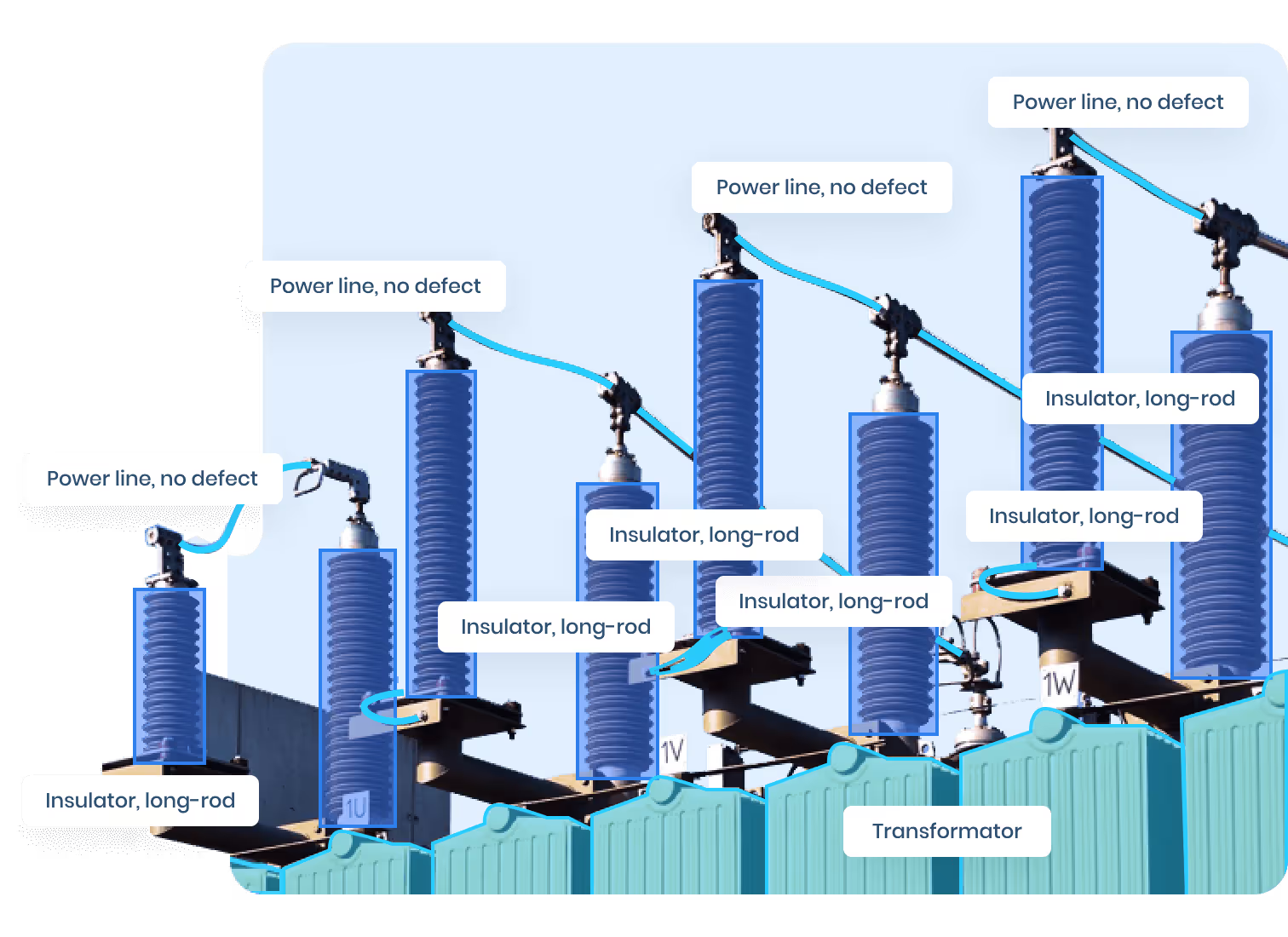

Anotando LiDAR Fusion: un desafío de alto riesgo 🎯

Si la configuración del oleoducto fuera compleja, anotación de los datos resultó aún más exigente. Etiquetar los datos de fusión con LiDAR es una tarea muy diferente en comparación con los simples recuadros delimitadores en 2D: se trabaja en un espacio 3D, con puntos dispersos, objetivos en movimiento y oclusiones ambientales.

La anotación tenía que ir más allá de las simples clasificaciones. Necesitaba captura la profundidad, el movimiento y la geometría, al tiempo que se mantiene la coherencia entre los marcos y las modalidades de los sensores.

Por qué la anotación LiDAR es tan desafiante

El LiDAR proporciona información de profundidad, pero carece de textura. Un árbol y un poste pueden arrojar señales de puntos idénticas. Las superficies de vidrio, los automóviles relucientes y los callejones estrechos a menudo distorsionan o borran los puntos por completo. Y a diferencia de las anotaciones de imágenes, en las que los objetos son visibles a todo color, el LiDAR suele capturar partial silhouettes, especially for dynamic objects like cyclists weaving between parked cars.

Major challenges included:

- Sparsity in the periphery — lower LiDAR beam resolution meant small objects like dogs or traffic cones were underrepresented.

- Occlusions — parked vehicles or pedestrians behind street furniture were often missing data in LiDAR, requiring reliance on visual camera input.

- Sensor inconsistency — even with calibration, some frame pairs were misaligned, demanding manual realignment or annotation at the projected layer only.

Hybrid Annotation Pipeline: Merging Precision with Speed

To tackle these hurdles, the team adopted a two-stage annotation workflow:

1. LiDAR-First Segmentation

- Annotators used 3D visualization tools to segment raw point clouds.

- Objects were grouped based on geometric clustering and known spatial priors (e.g., the average height of a pedestrian).

- This process was slower but established a base 3D ground truth.

2. Image-Guided Refinement

- RGB projections of point clouds were reviewed to verify object boundaries, resolve ambiguities, and correct for missed occlusions.

- Annotators could zoom in on projected images to catch small details like stroller wheels or bicycle handlebars.

The combination of spatial precision and visual cues allowed the team to label even complex scenes with confidence — intersections with overlapping pedestrian flows, alleys full of parked scooters, or narrow one-way roads filled with delivery vans.

Annotation Format and Output

For each frame, annotations included:

- 3D Bounding Boxes: For moving objects like cars, bikes, and people.

- Instance Segmentation Masks: On projected images for semantic classes like road, curb, building.

- Object Metadata: Speed, orientation, and motion type (static vs. dynamic).

- Scene Context Tags: Whether the scene occurred during rush hour, rainy weather, or night time.

Each annotated frame was saved in a multi-layer format:

.jsonfor metadata and object-level tags.binfor raw point cloud segmentation.pngoverlays for QA visualizations

All assets were linked using a unified frame ID system and checked through automated consistency validators before QA review.

Building a Human-in-the-Loop QA Engine

Manual annotations were only the beginning. A human-in-the-loop quality assurance process was embedded to catch inconsistencies across time and modality.

Key QA layers included:

- Frame-to-frame continuity checks: To ensure an object wasn’t mislabeled halfway through its trajectory

- 3D-to-2D overlay review: Each LiDAR label was validated by projecting it into image space and confirming it matched visual boundaries

- Edge case Scale AItion: Complex scenarios (e.g., reflections, occlusions) were flagged for expert annotator review

The QA team used custom dashboards that surfaced error-prone classes and scenes with missing metadata. This approach reduced rework by 37%, freeing up more time for new scene annotation.

Labeling Strategy: Segment Smart, Not Hard 🧠

Full-scene manual segmentation would’ve required thousands of hours — unscalable. So the team adopted a mixed strategy:

Semantic + Instance Hybrid

- Semantic segmentation was used for drivable areas, sidewalks, and bike paths

- Instance segmentation was used for dynamic objects like people and cars

Region-of-Interest (ROI) Prioritization

Instead of annotating all 360° data, focus was put on the front 120° cone, which matched the scooter’s navigation priority.

This significantly reduced labor hours without affecting model performance.

Smart Use of Pre-Labels and Model-Assisted QA ✅

To maintain accuracy without inflating costs, the team leveraged pre-trained AI models to generate rough masks and bounding boxes.

Here's how it worked:

- Mask R-CNN was used on camera frames

- Semantic scene completion models guided missing LiDAR patches

- Annotators received suggestions — not answers — for each frame

A separate QA layer validated label consistency across temporal frames. This reduced annotation revisions by 40%, speeding up delivery by nearly 3 weeks.

Label Governance: Revisions, Edge Cases, and Versioning 🔁

Urban environments throw curveballs: kids running, parked scooters, reflective glass, moving shadows. So, a versioning strategy was implemented.

Label Versioning System

- v1.0: MVP delivery with known limitations

- v1.1: Included extra segmentation for edge cases flagged in QA

- v2.0: Post-deployment feedback integrated into AI model retraining

Changes were tracked in a Git-based system with scene IDs and reviewer notes. Clients could trace any label back to the original annotator + QA reviewer.

Lessons Learned: What Future Teams Should Know 🧩

Every AI project teaches more than it solves. Here's what came out of this one:

✅ What Worked

- Hybrid annotation strategies cut hours without cutting corners

- Model-assisted labeling reducción de la fatiga y aumento del rendimiento

- Bucles de retroalimentación tempranos con IA, los ingenieros evitaron la desalineación de los conjuntos de datos

⚠️ Lo que no funcionó (al principio)

- Ambición de etiquetado integral rompió con las restricciones del mundo real

- Deriva del sensor requirió una recalibración más frecuente de lo esperado

- Callejones estrechos zonas de sombra GPS creadas: mitigadas solo con correcciones de IMU

🔁 Qué cambió

La startup originalmente imaginó un conjunto de datos único para todos. Pero aprendieron a priorizar las zonas de percepción críticas, y planificar varias versiones de conjuntos de datos que evolucionan con la pila de IA.

Impacto: más allá del conjunto de datos 📈

Este conjunto de datos no era solo una entrega. Se convirtió en la base de la cartera de IA de la startup.

- Permitió el entrenamiento de modelos de seguimiento de objetos y evitación de obstáculos

- Sirvió como material de demostración para presentaciones de inversores y solicitudes de subvenciones

- Se reutilizó para realizar pruebas internas en 3 nuevas ciudades a las que se expandió la startup

Lo que es más importante, le dio a la startup un ventaja patentada. A diferencia de los conjuntos de código abierto, este reflejaba sus medio ambiente, sus vehículos, y sus caso de uso.

Conclusión: Construir de forma más inteligente, no solo más grande 🚀

Crear un conjunto de datos de fusión LiDAR en un contexto urbano no es poca cosa. Sin embargo, con una gestión inteligente de los osciloscopios, los flujos de trabajo de preetiquetado y las estrategias de calibración precisas, incluso un equipo pequeño puede ofrecer un conjunto de datos que supere su peso.

Si su sistema de IA necesita «ver» el mundo como lo hace su producto, no confíe en conjuntos de datos genéricos. Crea el tuyo propio, estratégicamente.

¿Quiere crear un conjunto de datos multimodales adaptado a su proyecto de movilidad o robótica? Hablemos de cómo podemos ayudar, desde la captura hasta el control de calidad.

👉 DataVLab y cocreemos el futuro de la percepción de las máquinas.