Die Vision des Startups: Intelligentere Mikromobilität durch KI 🛴

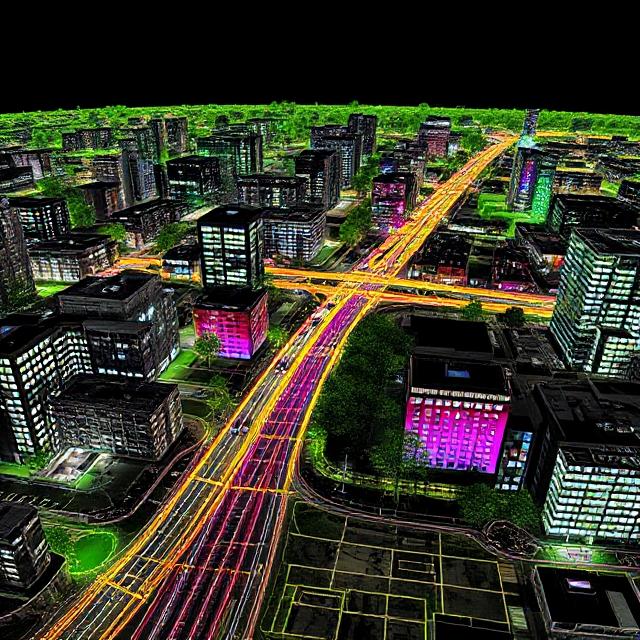

Der Kunde — ein durch Risikokapital finanziertes Startup mit Sitz in Nordeuropa — hatte eine mutige Mission: den Transport auf der letzten Meile mit KI-gestützten Mikromobilitätslösungen neu zu gestalten. Denken Sie an E-Scooter, autonome Bürgersteigroboter und kompakte Lieferfahrzeuge, die ihre Umgebung verstehen und Entscheidungen in Echtzeit treffen können.

Um diese Vision Wirklichkeit werden zu lassen, brauchten sie mehr als nur ein Fahrzeug — sie brauchten Wahrnehmung. Und das erforderte robuste Daten:

- Kommentierte LiDAR-Punktwolken

- Synchronisierte Kameraaufnahmen

- Präzise GPS-Zeitstempel

- Umfangreiche semantische Bezeichnungen

Standarddatensätze wie KITTI oder Nus-Szenen waren zu verallgemeinert. Sie spiegelten nicht die Dichte, die Hindernisse oder das GPS-Jitter wider, die in historischen Stadtzentren mit Kopfsteinpflaster, engen Gassen und Fußgängerüberflutung typisch sind. Das Startup brauchte etwas Benutzerdefiniertes.

Projektumfang und Einschränkungen: Ambition und Realität in Einklang bringen 🧭

Die ursprüngliche Anfrage war ehrgeizig:

- Kombinieren Sie 3D-LiDAR-Scans mit den Daten der vorderen und hinteren Stereokamera und IMU-/GPS-Protokollen

- Kommentieren Sie bewegliche Objekte (Autos, Fahrräder, Fußgänger) und statische Infrastrukturen (Bordsteine, Verkehrsschilder, Masten)

- Stellen Sie panoptische Segmentierung für kritische Zonen wie Gehwege und Fahrradwege bereit

- Liefert 200 Szenen aus 5 Städten innerhalb von 3 Monaten

🔍 Aber hier ist die Realität:

- Datengröße pro Szene: ~2—4 GB unkomprimiert

- Komplexität der Fusion: Die Frame-Ausrichtung erforderte eine präzise zeitliche Synchronisation

- LiDAR-Drift in engen Gassen war ein wiederkehrendes Problem

- Mehrere Sensoren verursachte Fehlausrichtungen, die eine ständige Kalibrierung erforderten

Um das Budget und die Zeit einzuhalten, änderte sich der Umfang während des Projekts — eine Entscheidung, die den Kunden letztendlich vor Burnout und Ressourcenverschwendung bewahrte. Wir erklären Ihnen wie.

Von der Roherfassung bis hin zu fusionsbereiten Daten: Einrichtung der Pipeline 🔧

Auf den ersten Blick scheint das Sammeln von Sensordaten eine einfache Aufgabe zu sein — fahren Sie das Fahrzeug, sammeln Sie Aufzeichnungen und senden Sie die Dateien an Ihr Labeling-Team. Aber in Wirklichkeit ist es so, dass die Umwandlung von rohen Multisensor-Eingaben in fusionsbereiter, annotationsfreundlicher Datensatz ist ein technisch anspruchsvoller Prozess, der Hardware, Software und Datentechnik betrifft.

Das Startup für urbane Mobilität erkannte schnell, dass Die Fusionspipeline selbst wäre der Dreh- und Angelpunkt des gesamten Projekts. Ohne eine gut strukturierte Pipeline würden selbst die besten Annotatoren durch Inkonsistenzen, fehlende Frames und Synchronisationsfehler gebremst.

So hat das Team die Fusionsherausforderung Schritt für Schritt gemeistert.

Multisensor-Hardware-Setup: Das Capture-Fahrzeug

Um die städtische Umgebung genau wahrzunehmen, wurde das Fahrzeug mit einem speziellen Sensorsystem ausgestattet, das Daten in Echtzeit sammelte. Zu den wichtigsten Komponenten gehörten:

- LiDAR-Sensor (Velodyne VLP-32C): Aufgenommene 360°-Punktwolken mit hoher Auflösung bei 10 Hz, ideal für die Erfassung von 3D-Geometrie in urbanen Szenen.

- Stereo-RGB-Kameras: Zwei 1080p-Frontkameras lieferten den visuellen Kontext und halfen bei der semantischen Segmentierung, was besonders in verdeckten oder mehrdeutigen Bereichen nützlich ist.

- GPS mit RTK-Korrektur: Lieferte eine zentimetergenaue Ortungsgenauigkeit, die in dicht besiedelten städtischen Gebieten mit GPS-Schattenzonen von entscheidender Bedeutung ist.

- Trägheitsmesseinheit (IMU): Aufgezeichnete Neigung, Gier und Beschleunigung zur Unterstützung der Sensorfusion und zur Korrektur der GPS-Drift.

- Datenlogger+Edge-Compute-Modul: Ein kompaktes Bordcomputersystem, das alle eingehenden Daten mit hoher Bandbreite mit Zeitstempel versehen, synchronisiert und gespeichert hat.

Dieses Setup ermöglichte es dem Roller, Aufnahmen zu machen originalgetreue räumliche und visuelle Informationen jede Sekunde — generiert ungefähr 2—4 GB an Rohdaten pro Szene.

Sensorsynchronisierung und Kalibrierung

Die Synchronisation war nicht optional — selbst geringfügige Zeitstempelabweichungen zwischen LiDAR und Kamerarahmen konnten die projizierten Overlays verzerren, was zu Annotationsfehlern und KI-Fehlausrichtungen führte.

Um dies zu lösen, implementierte das Team:

- Hochfrequenter Zeitstempelabgleich über ROS (Robot Operating System)

- Extrinsische Kalibrierung Verwendung von Schachbrettzielen für die LiDAR-Kameraausrichtung

- Protokolle zur Zeitsynchronisierung basierend auf PTP (Präzisionszeitprotokoll)

- Dynamische Rekalibrierung Verfahren, die alle 2—3 Tage nach der Erfassung ausgelöst werden, um der Sensordrift aufgrund von Vibrationen und Temperaturschwankungen Rechnung zu tragen

Jeder Datenstrom (LiDAR, Bild, GPS, IMU) wurde individuell mit einem Zeitstempel versehen und später mithilfe benutzerdefinierter Python-Skripte zusammengeführt, die Frames pro Millisekunde ausrichteten.

Datenformatierung und Speicherung

Nach der Kalibrierung und Zeitabgleich wurden die Daten für die nachgelagerte Verwendung formatiert:

- LiDAR-Punktwolken wurden gespeichert in

.pcdund.binFormate, kompatibel mit Visualisierungstools wie 3D öffnen und PCL. - Bilder wurden in Lossless gespeichert

.pngum Kantendetails für Anmerkungen beizubehalten. - Kombinierte Metadaten (einschließlich Pose, Überschrift und Bildindex) wurde verpackt in

.jsonund.yamlDateien pro Szene. - Szenensegmentierung Die Werkzeuge teilen lange Aufnahmen aus Gründen der Annotationseffizienz in 30-Sekunden-Slices auf.

Die Ausgabe? Ein fusionsfähiger Datensatz, der für Annotatoren und KI-Ingenieure gleichermaßen vorbereitet ist — sauber, synchronisiert und semantisch umfangreich.

Kommentieren von LiDAR Fusion: Eine Herausforderung, bei der viel auf dem Spiel steht 🎯

Wenn die Einrichtung der Pipeline komplex wäre, Kommentieren der Daten erwies sich als noch anspruchsvoller. Die Kennzeichnung von LiDAR-Fusionsdaten unterscheidet sich von einfachen 2D-Bounding-Boxes — Sie arbeiten im 3D-Raum mit spärlichen Punkten, sich bewegenden Zielen und Umgebungsokklusionen.

Die Annotation musste über einfache Klassifizierungen hinausgehen. Es musste Tiefe, Bewegung und Geometrie erfassen, während die Konsistenz über Frames und Sensormodalitäten hinweg gewahrt bleibt.

Warum LiDAR-Annotation so herausfordernd ist

LiDAR liefert Tiefeninformationen, aber es fehlt ihm an Textur. Ein Baum und ein Pol geben möglicherweise identische Punktsignaturen zurück. Glasoberflächen, glänzende Autos und enge Gassen verzerren oder löschen Punkte oft vollständig aus. Und im Gegensatz zu Bildanmerkungen, bei denen Objekte in voller Farbe sichtbar sind, erfasst LiDAR häufig partielle Silhouetten, insbesondere für dynamische Objekte wie Radfahrer, die sich zwischen geparkten Autos bewegen.

Zu den wichtigsten Herausforderungen gehörten:

- Sparsamkeit in der Peripherie — Eine geringere LiDAR-Strahlauflösung bedeutete, dass kleine Objekte wie Hunde oder Leitkegel unterrepräsentiert waren.

- Okklusionen — Bei geparkten Fahrzeugen oder Fußgängern hinter Straßenmöbeln fehlten häufig Daten in LiDAR, sodass man sich auf visuelle Kameraeingaben verlassen musste.

- Inkonsistenz des Sensors — Selbst bei der Kalibrierung waren einige Bildpaare falsch ausgerichtet, sodass nur auf der projizierten Ebene eine manuelle Neuausrichtung oder Anmerkung erforderlich war.

Hybride Annotations-Pipeline: Präzision mit Geschwindigkeit verbinden

Um diese Hürden zu überwinden, verabschiedete das Team eine zweistufiger Annotationsworkflow:

1. LIDAR-First-Segmentierung

- Die Annotatoren verwendeten 3D-Visualisierungstools, um rohe Punktwolken zu segmentieren.

- Objekte wurden auf der Grundlage geometrischer Clusterbildung und bekannter räumlicher Prioritäten (z. B. der durchschnittlichen Körpergröße eines Fußgängers) gruppiert.

- Dieser Prozess war langsamer, etablierte jedoch eine grundlegende 3D-Grundwahrheit.

2. Bildgesteuerte Verfeinerung

- RGB-Projektionen von Punktwolken wurden überprüft, um Objektgrenzen zu überprüfen, Mehrdeutigkeiten aufzulösen und verpasste Okklusionen zu korrigieren.

- Kommentatoren könnten projizierte Bilder vergrößern, um kleine Details wie Kinderwagenräder oder Fahrradlenker zu erfassen.

Die Kombination aus räumlicher Präzision und visuellen Hinweisen ermöglichte es dem Team beschriften Sie selbst komplexe Szenen mit Zuversicht — Kreuzungen mit überlappenden Fußgängerströmen, Gassen voller geparkter Motorroller oder enge Einbahnstraßen voller Lieferwagen.

Format und Ausgabe von Anmerkungen

Für jeden Frame waren folgende Anmerkungen enthalten:

- 3D-Bounding-Boxen: Für bewegliche Objekte wie Autos, Fahrräder und Menschen.

- Masken zur Instanzsegmentierung: Auf projizierten Bildern für semantische Klassen wie Straße, Bordstein, Gebäude.

- Objektmetadaten: Geschwindigkeit, Ausrichtung und Bewegungstyp (statisch oder dynamisch).

- Szenenkontext-Tags: Ob sich die Szene während der Hauptverkehrszeit, bei Regenwetter oder in der Nacht ereignet hat.

Jeder kommentierte Rahmen wurde in einem gespeichert mehrschichtiges Format:

.jsonfür Metadaten und Tags auf Objektebene.binfür die Segmentierung von rohen Punktwolken.pngOverlays für QA-Visualisierungen

Alle Assets wurden mithilfe eines einheitlichen Frame-ID-Systems verknüpft und vor der QA-Überprüfung durch automatische Konsistenzvalidatoren überprüft.

Aufbau einer Human-in-the-Loop-QS-Engine

Manuelle Anmerkungen waren nur der Anfang. EIN Human-in-the-Loop-Qualitätssicherungsprozess wurde eingebettet, um Inkonsistenzen zwischen Zeit und Modalität zu erkennen.

Zu den wichtigsten QA-Ebenen gehörten:

- Überprüfung der Kontinuität von Bild zu Bild: Um sicherzustellen, dass ein Objekt auf halber Strecke seiner Flugbahn nicht falsch beschriftet wurde

- Überprüfung von 3D-zu-2D-Overlays: Jedes LiDAR-Label wurde validiert, indem es in den Bildraum projiziert und bestätigt wurde, dass es den visuellen Grenzen entsprach

- Eskalation im Grenzfall: Komplexe Szenarien (z. B. Reflexionen, Okklusionen) wurden zur Überprüfung durch einen Experten durch den Kommentator markiert

Das QA-Team verwendete benutzerdefinierte Dashboards, die fehleranfällige Klassen und Szenen mit fehlenden Metadaten aufdeckten. Dieser Ansatz weniger Nacharbeit um 37%Dadurch bleibt mehr Zeit für neue Szenenkommentare.

Kennzeichnungsstrategie: Segment Smart, Not Hard 🧠

Die manuelle Segmentierung der gesamten Szene hätte Tausende von Stunden in Anspruch genommen — nicht skalierbar. Deshalb entschied sich das Team für eine gemischte Strategie:

Semantic + Instanzhybrid

- Semantische Segmentierung wurde für befahrbare Bereiche, Gehwege und Radwege verwendet

- Instanzsegmentierung wurde für dynamische Objekte wie Menschen und Autos verwendet

Priorisierung der Interessenregion (ROI)

Anstatt alle 360°-Daten zu kommentieren, lag der Fokus auf der vorderer 120°-Kegel, was der Navigationspriorität des Rollers entsprach.

Dies reduzierte die Arbeitsstunden erheblich. ohne Beeinträchtigung der Modellleistung.

Intelligenter Einsatz von Pre-Labels und Model-Assisted QA ✅

Um die Genauigkeit aufrechtzuerhalten, ohne die Kosten in die Höhe zu treiben, nutzte das Team vorab trainierte KI-Modelle zur Generierung grobe Masken und Bounding-Boxes.

So hat es funktioniert:

- Die Maske R-CNN wurde für Kamerarahmen verwendet

- Semantische Szenenvervollständigungsmodelle führten zu fehlenden LiDAR-Patches

- Die Kommentatoren erhielten Vorschläge — keine Antworten — für jeden Frame

Eine separate QA-Ebene überprüfte die Konsistenz der Beschriftungen über Zeitrahmen hinweg. Dadurch wurden die Überarbeitungen von Anmerkungen um Folgendes reduziert 40%, was die Lieferung um fast 3 Wochen beschleunigt.

Label-Governance: Überarbeitungen, Randfälle und Versionierung 🔁

Urbane Umgebungen werfen Curvebälle auf: rennende Kinder, geparkte Roller, reflektierendes Glas, bewegte Schatten. Daher wurde eine Versionierungsstrategie implementiert.

Label-Versionierungssystem

- v1.0: MVP-Bereitstellung mit bekannten Einschränkungen

- v1.1: Zusätzliche Segmentierung für Randfälle, die in der Qualitätssicherung gekennzeichnet wurden, enthalten

- v2.0: Feedback nach der Bereitstellung ist in die Umschulung des KI-Modells integriert

Änderungen wurden in einem Git-basierten System mit Szenen-IDs und Anmerkungen der Rezensenten verfolgt. Kunden konnten jedes Etikett bis zum ursprünglichen Kommentator und zum QA-Rezensenten zurückverfolgen.

Gelernte Erkenntnisse: Was zukünftige Teams wissen sollten 🧩

Jedes KI-Projekt lehrt mehr als es löst. Folgendes ist dabei herausgekommen:

✅ Was hat funktioniert

- Hybride Annotationsstrategien Stunden sparen, ohne Abstriche zu machen

- Modellgestützte Kennzeichnung geringere Ermüdung und erhöhter Durchsatz

- Frühe Feedback-Schleifen mit KI-Ingenieuren wurde eine Fehlausrichtung von Datensätzen verhindert

⚠️ Was (zuerst) nicht funktioniert hat

- Ehrgeiz beim Etikettieren der gesamten Szene brach unter realen Einschränkungen

- Sensordrift erforderte eine häufigere Rekalibrierung als erwartet

- Enge Gassen erstellte GPS-Schattenzonen — nur mit IMU-Korrekturen gemildert

🔁 Was hat sich geändert

Das Startup stellte sich ursprünglich einen Datensatz vor, der für alle passt. Aber das haben sie gelernt priorisieren Sie kritische Wahrnehmungszonen, und Plan für mehrere Datensatzversionen die sich mit dem KI-Stack weiterentwickeln.

Wirkung: Jenseits des Datensatzes 📈

Dieser Datensatz war nicht nur ein Ergebnis. Er wurde zur Grundlage der KI-Pipeline des Startups.

- Ermöglicht das Training von Modellen zur Objektverfolgung und Hindernisvermeidung

- Diente als Demo-Material für Investorengespräche und Zuschussanträge

- Wurde für interne Tests in 3 neuen Städten wiederverwendet, in die das Startup expandierte

Am wichtigsten ist, dass es dem Startup eine proprietärer Vorteil. Im Gegensatz zu Open-Source-Sets spiegelte sich dieses wider ihr Umwelt, ihr Fahrzeuge und ihr Anwendungsfall.

Fazit: Intelligenter bauen, nicht nur größer 🚀

Die Erstellung eines LiDAR-Fusionsdatensatzes in einem städtischen Kontext ist keine leichte Aufgabe. Aber mit intelligenter Verwaltung des Datenumfangs, Arbeitsabläufen vor der Etikettierung und präzisen Kalibrierungsstrategien kann selbst ein kleines Team einen Datensatz liefern, der sein Gewicht übertrifft.

Wenn Ihr KI-System die Welt so „sehen“ muss, wie es Ihr Produkt tut, verlassen Sie sich nicht auf generische Datensätze. Bauen Sie Ihr eigenes, strategisch.

Sie möchten einen multimodalen Datensatz erstellen, der auf Ihr Mobilitäts- oder Robotikprojekt zugeschnitten ist? Lassen Sie uns darüber sprechen, wie wir Ihnen helfen können — von der Erfassung bis zur Qualitätssicherung.

👉 DataVLab und lassen Sie uns gemeinsam die Zukunft der maschinellen Wahrnehmung gestalten.