Por qué es importante la anotación LiDAR y Sensor Fusion

Los vehículos autónomos (AV) dependen de una comprensión ambiental precisa para tomar decisiones seguras y eficaces. Esto depende en gran medida de fusión de sensores—la integración de datos de múltiples fuentes, como cámaras, LiDAR (detección de luz y alcance), radares, GPS y unidades de medición inercial (IMU). Entre ellas, el LiDAR proporciona datos espaciales 3D de alta precisión, que actúan como los ojos del vehículo.

Sin embargo, las nubes de puntos LiDAR sin procesar o los datos de los sensores por sí solos no son suficientes. Estas entradas deben ser etiquetadas y estructuradas—una tarea que requiere precisión tanto computacional como humana. Al anotar los datos del LiDAR y los datos de los sensores fusionados, se descubre el verdadero poder de los modelos de aprendizaje automático en la percepción, que incluyen:

- Detección de obstáculos 🧱

- Rastreo de objetos 🏃 ♂️

- Segmentación de áreas manejables 🚧

- Estimación de profundidad y mapeo de rango 🎯

- Predicción del comportamiento de agentes dinámicos 🔮

De acuerdo con McKinsey, el éxito de la conducción autónoma depende de la precisión de la percepción, que comienza con los datos anotados.

Desafíos únicos en la anotación LiDAR

A diferencia de los datos de la cámara, LiDAR produce Nubes de puntos 3D—dispersos, desestructurados y, a menudo, ruidosos. Cada fotograma puede contener cientos de miles de puntos, que representan superficies alrededor del AV. Estos son los principales obstáculos a la hora de anotar estos datos:

Alta dimensionalidad

Los datos LiDAR no son planos. Es un mapa espacial 3D que requiere herramientas especializadas y anotadores capacitados para interpretar las distancias, la elevación y las oclusiones.

Oclusión y escasez

LiDAR tiene problemas con los objetos ocluidos y los materiales reflectantes. Es posible que los peatones detrás de los arbustos o los vehículos junto a los camiones solo sean visibles parcialmente, lo que hace que la anotación sea más compleja.

Coherencia temporal

Las anotaciones en los marcos LiDAR secuenciales deben permanecer coherentes para las tareas de seguimiento de objetos y predicción del comportamiento.

Desalineación del sensor

Al fusionar el LiDAR con cámaras o radares, la desviación de calibración o la falta de coincidencia en la marca de tiempo pueden provocar desalineaciones espaciales, lo que hace que la anotación sea incoherente.

Complejidad semántica

No todos los objetos son iguales: anotar ciclistas, patinetes y señales de tráfico en un espacio 3D exige una taxonomía semántica y una conciencia espacial refinadas.

Estos desafíos no son solo técnicos, sino prácticos. Sin las estrategias correctas, incluso los datos más detallados dejan de ser confiables para el entrenamiento de modelos.

Dominar las técnicas de anotación LiDAR

Exploremos ahora cómo los expertos abordan la anotación LiDAR teniendo en cuenta la precisión y la Scale AIbilidad.

1. Cajas delimitadoras 3D: el estándar de la industria

La forma más común de anotar objetos en LiDAR es mediante Cajas delimitadoras 3D. Cada cuadro representa las dimensiones, la orientación y la clase de un objeto en un espacio tridimensional.

Las consideraciones clave incluyen:

- Rotación de guiñada: Los objetos necesitan una alineación de orientación (por ejemplo, vehículos que miran en direcciones diferentes)

- Ubicación del punto central: Asegurarse de que la caja esté alineada con el centroide verdadero

- Variación de tamaño: Adaptar cajas para objetos pequeños (por ejemplo, peatones) frente a objetos grandes (por ejemplo, camiones)

Plataformas como Escale la IA y Profundice la IA ofrecen kits de herramientas para simplificar estas anotaciones.

2. Segmentación semántica en el espacio 3D

Más granulares que las cajas, segmentación semántica clasifica cada punto de una nube con una etiqueta (por ejemplo, carretera, acera, poste, árbol). Es esencial para:

- Detección de superficie manejable

- Comprensión de la escena

- Localización y mapeo

Por ejemplo, el conjunto de datos abierto de Waymo utiliza una segmentación exhaustiva para entrenar a su equipo impulsor. Esta técnica suele aprovechar los modelos de aprendizaje profundo para preetiquetar y, a continuación, utiliza la corrección humana para perfeccionarlos.

3. Segmentación de instancias para agentes dinámicos

La segmentación de instancias lleva las cosas más allá: el etiquetado cada objeto único incluso dentro de la misma clase (por ejemplo, 5 peatones, no solo «peatón» en general).

Esto permite:

- Seguimiento multiobjeto (MOT)

- Previsión de trayectoria

- Modelado para evitar colisiones

Realizar anotaciones de esta forma lleva mucho tiempo, pero es inestimable para las aplicaciones en las que los AV deben interactuar con varias entidades en movimiento.

4. Etiquetado temporal en todos los marcos

Para mantener continuidad de etiquetas entre marcos, los anotadores vinculan objetos marco a marco mediante identificadores coherentes. Esto admite:

- Comprensión de la permanencia de objetos

- Modelado predictivo del comportamiento

- Precisión de fusión en varios cuadros

Las tuberías modernas integran esto con los cálculos de flujo óptico y movimiento del ego para mantener la precisión a lo largo del tiempo.

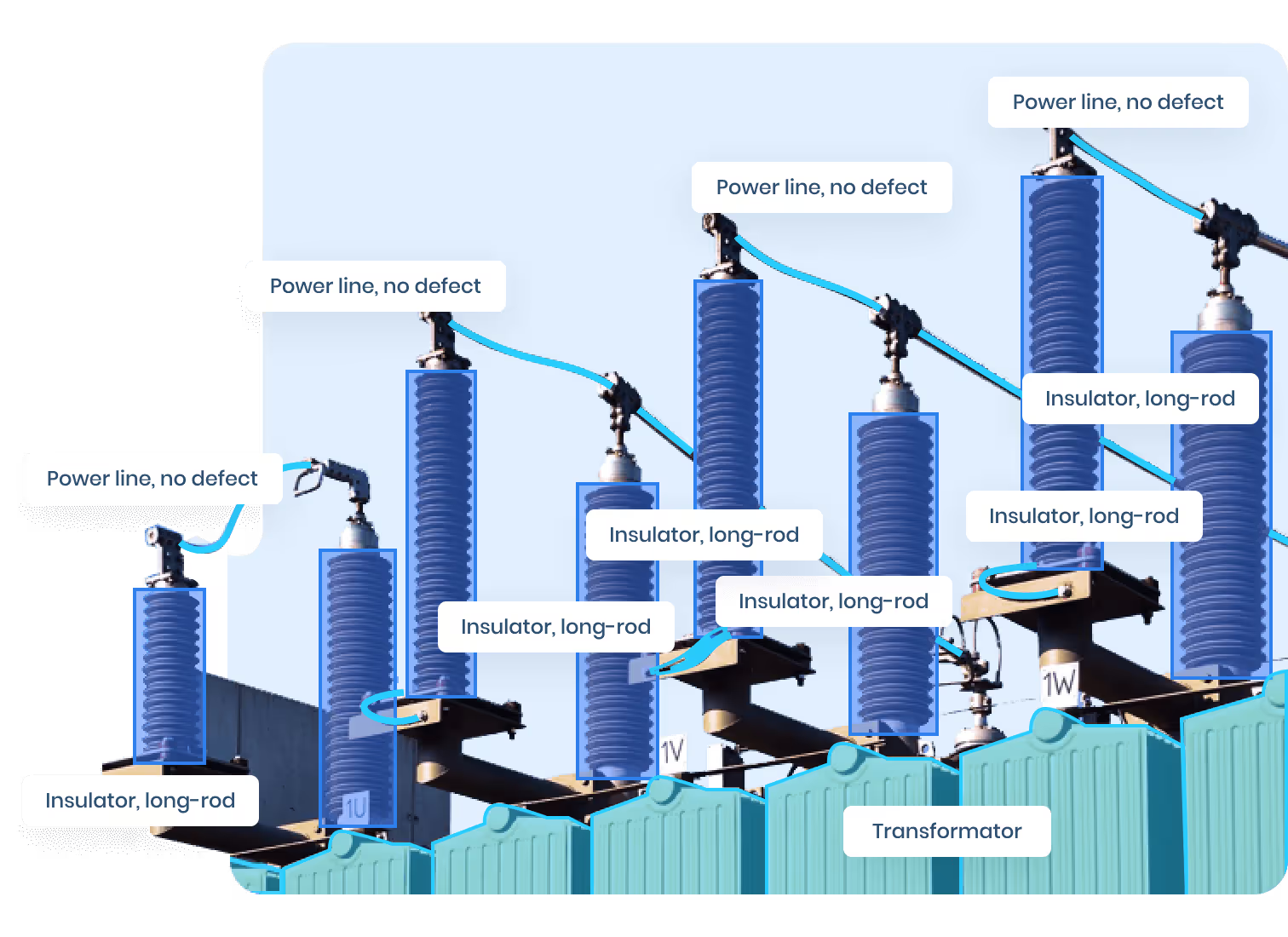

5. Técnicas de alineación por fusión de sensores

La combinación de las vistas de cámara y LiDAR permite comprender mejor las escenas, pero solo cuando están bien alineadas. Las técnicas incluyen:

- Matrices de calibración: Proyecciones 3D precalculadas → 2D

- Sincronización de marcas de tiempo: Interpolación temporal para plataformas móviles

- IA de alineación automática: Uso de modelos previamente entrenados para reproyectar datos en todos los dominios de los sensores

Algunas herramientas de código abierto como KITTI y Escenas nuestas proporcionan valiosas referencias de calibración.

El papel de la anotación humano-in-the-loop

Si bien la automatización acelera la anotación, humano al día (HITL) es clave para garantizar la calidad.

Las mejores prácticas incluyen:

- Etiquetado previo: Utilice modelos previamente entrenados para realizar anotaciones automáticas

- Revisión manual: Expertos capacitados verifican o corrigen

- Aprendizaje activo: Priorice el etiquetado de los casos inciertos o extremos

- Modelado de consenso: Combine varias anotaciones para una mayor confiabilidad

Plataformas de anotación con flujos de trabajo HITL integrados, como Labelbox o SuperAnnotate, mejoran significativamente la calidad a la vez que reducen los costos.

Control de calidad: más allá de la precisión

Los modelos AV entrenados con anotaciones ruidosas son peligrosos. Por eso son robustos Control de calidad (QC) los protocolos son fundamentales.

El control de calidad de primer nivel incluye:

- Métricas de IoU: Intersección sobre unión entre etiquetas predichas y humanas

- Controles aleatorios manuales: Revisión del 10 al 20% de los fotogramas etiquetados

- Scale AImiento de casos extremos: Dirigir las anomalías a los revisores superiores

- Etiquetado redundante: Varios anotadores etiquetan los mismos marcos para obtener consenso

Además, aprovechar paneles de anotación con métricas clave (como la velocidad de etiquetado, los tipos de error y la confusión entre clases de objetos) puede informar tanto sobre la formación de los anotadores como para las decisiones del proyecto.

Simulación y datos sintéticos: la nueva frontera

A medida que aumenta la demanda de datos anotados, datos sintéticos y de simulación están cambiando las reglas del juego en el desarrollo de sistemas de percepción de vehículos autónomos (AV). La recopilación de datos y el etiquetado manual tradicionales requieren mucho tiempo, son costosos y, a veces, incluso peligrosos, especialmente cuando se trata de situaciones de conducción poco frecuentes o peligrosas. Los datos sintéticos ofrecen una solución poderosa al generar conjuntos de datos fotorrealistas y totalmente anotados mediante programación.

Por qué los datos sintéticos están ganando terreno

Plataformas de datos sintéticos como Dominio paralelo, Cognata, y Profundice la IA permiten a los equipos audiovisuales crear ciudades virtuales completas, sistemas meteorológicos y comportamientos del tráfico para generar diversos conjuntos de datos. Cada píxel, cada punto LiDAR y cada señal de radar se generan con anotaciones perfectas sobre la verdad, eliminando los errores de etiquetado humano.

Los beneficios clave incluyen:

- Entornos controlados: Los desarrolladores pueden simular la lluvia, la nieve, la niebla o la conducción nocturna sin poner en riesgo la seguridad.

- Modelado de eventos raros: Genere fácilmente escenarios poco comunes o extremos, como adelantamientos de ambulancias, cruces de animales o escombros en la carretera.

- Diversidad de datos: Logre conjuntos de datos equilibrados sobre datos demográficos, tipos de vehículos, topologías de carreteras y condiciones urbanas/rurales.

- Rentabilidad: Una vez construidos, los motores de simulación pueden generar grandes conjuntos de datos con un mínimo de mano de obra humana, lo que reduce drásticamente los costos de anotación.

- Pruebas iterativas: Los desarrolladores pueden probar nuevos modelos rápidamente, retroalimentando escenarios sintéticos para volver a capacitarlos y validarlos.

Por ejemplo, un peatón corriendo por una autopista de varios carriles al anochecer puede verse una vez en un millón de fotogramas del mundo real. Con la simulación, se puede replicar cientos de veces en diferentes condiciones, construyendo robustez en los modelos de percepción.

Combinación de datos sintéticos y reales

Si bien los datos sintéticos son poderosos, no son una fórmula mágica. Por sí solos, pueden provocar que los modelos se adapten demasiado a los entornos virtuales «limpios». Por eso, los flujos de trabajo híbridos, que combinan conjuntos de datos sintéticos y del mundo real, son ahora el estándar de referencia.

Mejores prácticas para la integración sintética-real, incluya:

- Adaptación de dominio: Usa técnicas como CycleGan o Sim2Real Transfer para cerrar la brecha visual entre las escenas virtuales y reales.

- Canalizaciones de validación: Realice siempre pruebas en casos extremos del mundo real para detectar alucinaciones o puntos ciegos en modelos.

- Entrenamiento previo sintético y puesta a punto real: Entrene los modelos de percepción primero con datos sintéticos y luego refinelos con datos reales para generalizarlos.

Incluso las principales empresas audiovisuales, como Waymo y Aurora, reconocen públicamente el uso de canales de simulación para aumente la variedad de datos y llene las brechas, especialmente en escenarios poco frecuentes o peligrosos.

Errores comunes (y cómo evitarlos)

A pesar de los avances en los canales y herramientas de anotación, muchos equipos audiovisuales siguen enfrentándose a errores recurrentes que comprometen la calidad de los datos y el rendimiento del modelo. He aquí un análisis detallado de las trampas más comunes y de cómo evitarlas:

1. La anotación se desvía con el tiempo

A medida que los equipos crecen o rotan, aparecen inconsistencias en el etiquetado. Por ejemplo, un anotador puede etiquetar una camioneta como «automóvil», mientras que otro la clasifica correctamente. Con el tiempo, esto crea ruido en el conjunto de datos y reduce la confianza del modelo.

Cómo evitarlo:

- Establezca directrices de anotación y definiciones de clase nítidas.

- Audite regularmente las anotaciones anteriores para detectar la desviación y el reentrenamiento de los anotadores.

- Utilice las herramientas de validación automática de etiquetas para marcar las incoherencias.

2. Desalineación por fusión

La fusión de sensores requiere calibración perfecta en píxeles entre modalidades. Un par de cámaras y LIDAR desalineado producirá casillas delimitadoras que aparecerán «apagadas» en cualquiera de las vistas, lo que generará señales de entrenamiento deficientes.

Cómo evitarlo:

- Vuelva a calibrar los sensores con frecuencia, especialmente después de cambiar el hardware.

- Utilice métodos de corrección de alineación automatizados o sistemas SLAM.

- Valide los resultados de Fusion manualmente antes de pasarlos a los conjuntos de datos de producción.

3. Clases demasiado genéricas

Si su taxonomía es demasiado vaga (por ejemplo, agrupar sedanes, autobuses y motocicletas en «vehículos»), es posible que su modelo tenga dificultades para diferenciar entre los actores críticos de la carretera.

Cómo evitarlo:

- Construye un taxonomía jerárquica con granularidad de subclase (por ejemplo, vehículo → sedán, SUV, camión, etc.).

- Asegúrese de que haya suficientes ejemplos de cada subclase en los datos de entrenamiento.

- Usa datos sintéticos para complementar subclases poco frecuentes.

4. Ignorando los casos extremos

Los AV deben manejarse eventos poco comunes pero críticos, como personas en silla de ruedas, letreros de construcción o mascotas corriendo por la carretera. Están infrarrepresentados en los conjuntos de datos públicos.

Cómo evitarlo:

- Cree una biblioteca de casos extremos a partir de conjuntos de datos abiertos, simulaciones y registros internos.

- Priorice la anotación manual para estos eventos poco frecuentes.

- Incluya estos ejemplos en modelos de reentrenamiento y pruebas de esfuerzo.

5. Cuellos de botella en la garantía de calidad

Muchos equipos tratan los controles de calidad como un proceso único. Sin embargo, la anotación es un oleoducto vivo—los errores se multiplican a medida que los datos se Scale AIn.

Cómo evitarlo:

- Configure flujos de trabajo de control de calidad continuos con métricas como MioU, falsos positivos y cobertura de etiquetas.

- Utilice las jerarquías de revisores (junior > senior > auditor) para detectar errores en varios niveles.

- Introduzca la verificación puntual de los datos antiguos y recién anotados.

6. Descuidar la coherencia temporal

Para tareas como el seguimiento de objetos o la predicción de movimiento, el etiquetado incoherente entre fotogramas arruina el contexto temporal. Por ejemplo, si la identificación de un peatón cambia a mitad de la secuencia, la previsión de la trayectoria deja de ser fiable.

Cómo evitarlo:

- Utilice el seguimiento de identidad automatizado basado en vectores de movimiento.

- Entrene a los anotadores para que mantengan la persistencia de los objetos de forma manual cuando falle la automatización.

- Aproveche el aprendizaje autosupervisado para rastrear la estabilidad a lo largo del tiempo.

Casos de uso de anotaciones en toda la pila AV

Las anotaciones no son solo para la percepción. Se extienden por todo el conjunto audiovisual:

- Localización y mapeo: Los sistemas SLAM requieren puntos de referencia etiquetados para la conciencia ambiental

- Planificación y control: Comprender la intención de los peatones afecta la forma en que responde el AV

- Predicción de comportamiento: Las trayectorias anotadas y los historiales de movimiento de los agentes se incorporan a los módulos de IA predictiva

- Validación reglamentaria: La anotación de alta calidad es compatible con los estándares de auditabilidad y seguridad (por ejemplo, ISO 26262)

Al invertir en la calidad de las anotaciones desde el principio, las empresas audiovisuales reducen las costosas fallas en casos extremos más adelante.

Qué sigue: el futuro de LiDAR y Fusion Annotation

El panorama de las anotaciones está evolucionando. Espere ver:

- Aprendizaje autosupervisado: Reducir la necesidad de etiquetas manuales

- Modelos básicos para nubes de puntos: Similar a GPT o CLIP, pero para 3D

- IA multimodal: Combinación de visión, lenguaje y LiDAR para una mejor comprensión de las escenas

- Etiquetado en tiempo real: Anotación en el dispositivo para fomentar el aprendizaje continuo

- Anotación federada: Etiquetado seguro y distribuido entre los equipos de todo el mundo

A medida que el ecosistema autónomo madure, también lo harán las expectativas en torno a los datos anotados, no solo en volumen, sino también en valor por etiqueta.

Vamos a prepararte para lo que viene 🚀

Ya sea que esté creando la tecnología audiovisual de próxima generación, diseñando conjuntos de datos o evaluando a los proveedores de inteligencia artificial, comprender cómo funciona la anotación de fusión de sensores y LiDAR no es negociable.

👉 ¿Necesita ayuda con la anotación de datos audiovisuales de alta calidad o la simulación de casos extremos?

En DataVLab, nos especializamos en flujos de trabajo de etiquetado avanzados para datos LiDAR, vídeo y multimodales, en los que confían tanto las empresas emergentes como los equipos empresariales.

Convirtamos sus datos en decisiones de conducción más seguras.

Póngase en contacto con nuestro equipo de expertos y prepare hoy su pila de percepciones para el futuro.