La obsesión por el Big Data: dónde empezó todo

Los macrodatos surgieron como una palabra de moda a principios de la década de 2010, al subirse a la ola del almacenamiento en la nube, Internet de alta velocidad y la explosión del contenido digital. En aquel momento, la lógica era simple: cuantos más datos, mejor será la IA.

Esta creencia se vio reforzada por el auge del aprendizaje profundo. Avances como ImageNet mostró cómo grandes conjuntos de datos anotados podían impulsar modelos de última generación en tareas de visión y lenguaje. Las empresas se apresuraron a recopilar la mayor cantidad de datos posible y, a menudo, priorizaron la cantidad sobre la calidad.

Pero pasó algo interesante...

A medida que los sistemas de IA maduraban, surgieron nuevos desafíos:

- Sobreajuste del modelo al ruido y a los patrones irrelevantes

- Aumento de los costos de almacenamiento, etiquetado y limpieza de datos

- Sesgos imprevistos en conjuntos de datos grandes e incontrolados

- Incapacidad para adaptar los modelos a entornos periféricos o específicos de un dominio

Y así, el péndulo comenzó a oscilar.

La calidad triunfa sobre la cantidad: por qué los conjuntos de datos más pequeños están ganando terreno

Lo que los investigadores y profesionales se están dando cuenta cada vez más es lo siguiente: no se trata de cuántos datos tiene, sino de qué tan relevantes, limpios y bien etiquetados son.

🎯 La precisión impulsa una mejor señal

Los conjuntos de datos masivos suelen incluir:

- Duplicados

- Muestras irrelevantes

- Datos mal etiquetados o ruidosos

- Estuches periféricos con baja representación

Por otro lado, pequeños conjuntos de datos seleccionados con intención y contexto dé a su modelo una señal más clara. Evitan la dilución de patrones poco comunes y ayudan a entrenar al modelo lo que más importa.

💰 Costos más bajos, resultados más rápidos

Los conjuntos de datos a gran Scale AI son caros:

- La anotación lleva tiempo y trabajo (especialmente en ámbitos regulados como la atención médica)

- La limpieza y la validación requieren un esfuerzo de ingeniería significativo

- Los recursos de almacenamiento y procesamiento aumentan con el tamaño del conjunto de datos

Los conjuntos de datos más pequeños se pueden etiquetar, limpiar y procesar más rápido, lo que permite ciclos de desarrollo más cortos y más experimentación por dólar.

⚖️ Cumplimiento ético y legal

En ámbitos de alto riesgo (por ejemplo, finanzas, defensa, medicina), los conjuntos de datos masivos e incontrolados suelen ser pesadillas legales. Los conjuntos de datos más pequeños y diseñados específicamente ofrecen mejores resultados:

- Procedencia de los datos

- Seguimiento del consentimiento

- Alineación regulatoria (p. ej., GDPR, HIPAA)

Cuando la precisión y la responsabilidad importan, cuanto más grande no es mejor: es más riesgoso.

El mito del modelo universal

Una de las mayores trampas del pensamiento de big data es suponer que un modelo genérico grande funcionará para todos. Pero el contexto lo es todo.

- Una modelo entrenada en millones de imágenes de venta minorista puede tener un mal desempeño en artículos de moda de lujo

- Un modelo de conversión de voz a texto entrenado en podcasts en inglés puede tener problemas con acentos específicos

- Un detector de señales de tráfico entrenado en los EE. UU. podría fallar en Nepal o Kenia

Los conjuntos de datos pequeños le permiten: afinar para la relevancia local, algo que ningún modelo global puede lograr de manera inmediata.

💡 Lección: Trenes de datos contextuales pequeños especialista modelos, y estos a menudo superan a los genéricos e inflados.

Donde los conjuntos de datos pequeños superan a los grandes 🔍

El cambio hacia conjuntos de datos más pequeños y más seleccionados no es teórico, sino que se está produciendo en todos los sectores con beneficios cuantificables. A continuación, presentamos información más profunda sobre los mercados verticales en los que predominan los datos pequeños:

🧠 Diagnósticos neurológicos y de salud mental

En salud mental y neurología, los datos de imágenes suelen ser escasos y las anotaciones son increíblemente delicadas. Modelos de IA entrenados en unos cientos de muestras de MRI o EEG anotadas por expertos a menudo superan a los conjuntos de datos más grandes y ruidosos.

Por ejemplo, los investigadores que desarrollan modelos para detectar la enfermedad de Alzheimer de inicio temprano o predecir las convulsiones dependen en gran medida de anotaciones verificadas por especialistas de patrones de ondas cerebrales. El ruido en grandes conjuntos de datos puede inducir a error a estos modelos, mientras que señales enfocadas y etiquetadas por expertos ayudan a identificar los biomarcadores con precisión quirúrgica.

📌 Leer más: Nature

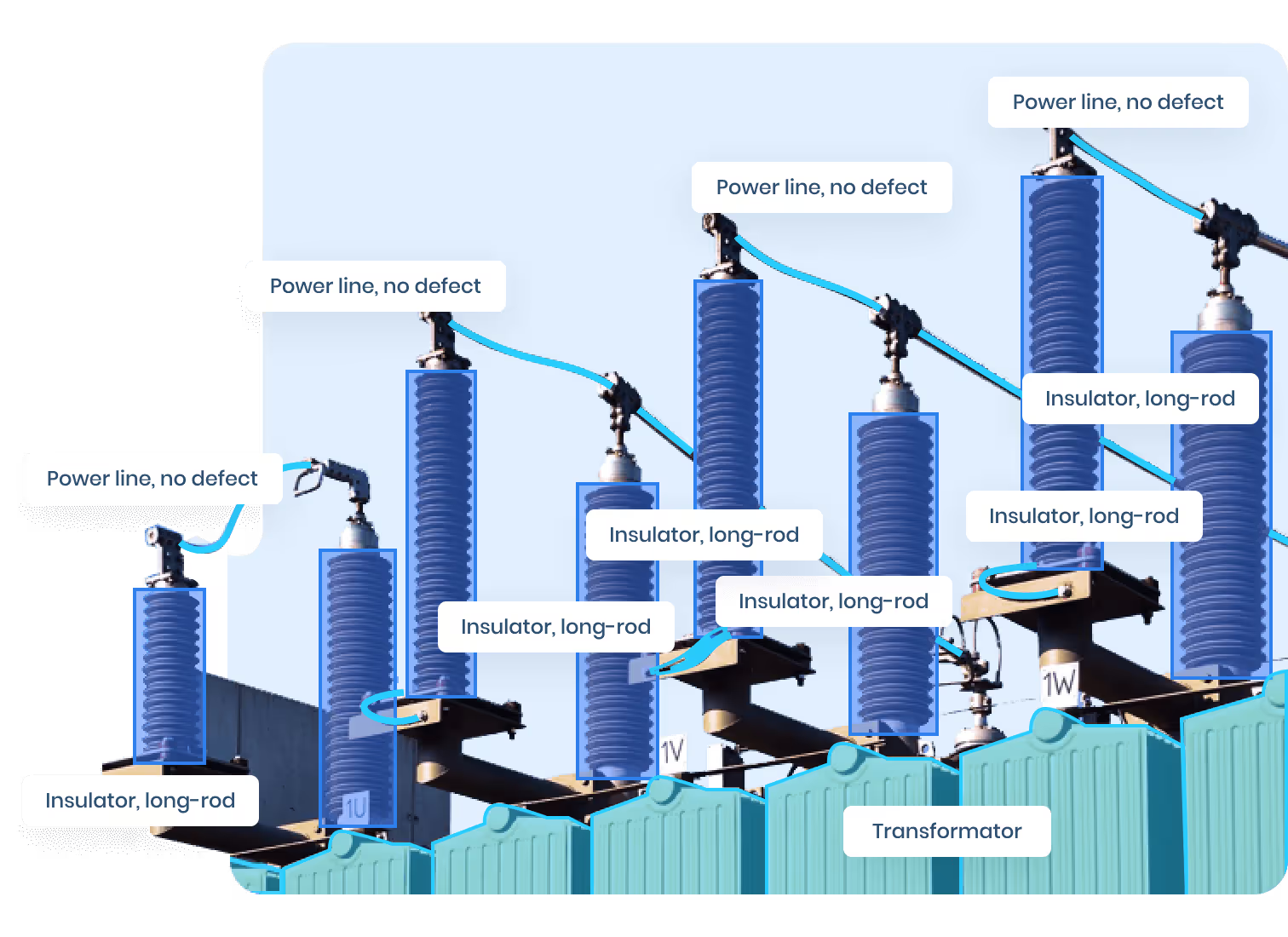

🏭 Fabricación inteligente e IoT industrial

En las fábricas automatizadas, el tiempo es dinero. La detección de anomalías, como grietas finas o puntos calientes térmicos, requiere sistemas de IA que reaccionen en milisegundos. Los grandes conjuntos de datos recopilados a lo largo de meses pueden incluir solo unos pocos fallos relevantes y cientos de horas de irrelevancia.

Aquí, los ingenieros prefieren conjuntos de datos pequeños que consisten solo en casos extremos recopilados durante simulaciones, pruebas de esfuerzo o etapas de control de calidad. Esto asegura que el modelo aprenda exactamente qué constituye un defecto, condiciones no generales.

Además, para la fabricación de bajo volumen y alta precisión (como dispositivos aeroespaciales o médicos), cada unidad producida es única. Modelos entrenados en conjuntos de datos pequeños por producto funcionan mejor que los modelos industriales genéricos.

🌍 Monitoreo ambiental y agricultura

En la tecnología agrícola, la diferencia entre un cultivo sano y un brote de enfermedad puede ser de unos pocos píxeles. En lugar de alimentar modelos con miles de imágenes de satélite, las empresas emergentes y los investigadores suelen centrarse en:

- Unos cientos imágenes geolocalizadas y secuenciadas en el tiempo por región de cultivo

- Anotaciones realizadas por agrónomos locales

- Signos de enfermedad, plaga o estrés hídrico específicos del contexto

Esto da como resultado modelos optimizados para la región que superan a las soluciones de uso general, como las basadas únicamente en PlanetScope o Sentinel-2.

🌾 Vea el ejemplo: IA de la FAO para una agricultura inteligente

🧬 Descubrimiento de fármacos y modelado de proteínas

En biofarmacéutica y ciencia molecular, la calidad lo es todo. Los conjuntos de datos aquí suelen contener entradas poco frecuentes, caras o de alto riesgo, como datos de cristalografía, estructuras de plegamiento de proteínas o resultados de bioensayos.

En lugar de raspar bases de datos masivas, los investigadores desarrollan conjuntos de datos enfocados de 50 a 200 moléculas, utilizando etiquetas informadas sobre la física, experimentos de laboratorio y revisiones de expertos. Luego, se utilizan para ajustar los modelos de IA generativa, como AlphaFold, o los sistemas de generación de moléculas basados en la difusión.

Pequeña, las entradas de alta fidelidad permiten grandes ganancias, como la identificación de nuevos fármacos candidatos o la predicción de las afinidades de unión con una precisión similar a la de un laboratorio.

🧯 Seguridad y protección públicas

Modelos centrados en la seguridad, como los que se utilizan para análisis del comportamiento de multitudes, detección de caídas o intrusión en zonas restringidas — debe funcionar a la perfección en situaciones raras pero de alto riesgo.

En lugar de entrenarse con miles de horas de imágenes sin incidentes, los sistemas de IA funcionan mejor cuando se entrenan en docenas de clips para bordes comisariado para:

- Hora del día

- Ángulo de cámara

- Postura o comportamiento humano

- Trayectorias de movimiento

Esto también ayuda a reducir los falsos positivos y mejora la explicabilidad del modelo, algo fundamental cuando las decisiones afectan a la seguridad física o a la respuesta de emergencia.

El verdadero costo de ir a lo grande (y a ciegas)

Los grandes conjuntos de datos conllevan cargas ocultas que van más allá del simple almacenamiento:

- Fatiga por etiquetado de datos: anotadores de baja calidad que revisan miles de muestras irrelevantes

- Incoherencia en las anotaciones: Varias etiquetadoras sin directrices claras

- Hinchazón modelo: Modelos sobreparametrizados que aprenden correlaciones espurias

- Tiempos de entrenamiento más largos: Más computación, mayor huella de carbono

- Depurar pesadillas: Es difícil encontrar por qué un modelo falla con millones de ejemplos de entrenamiento

💡 En cambio, los pequeños conjuntos de datos de alta calidad ofrecen transparencia, control y interpretabilidad — rasgos cruciales para la IA de producción.

Cómo seleccionar un conjunto de datos pequeño y poderoso: lo que realmente importa

Entonces, ¿cómo se crea un conjunto de datos pequeño que pueda rivalizar (o superar) a uno masivo?

🔍 La relevancia frente a la aleatoriedad

Utilice expertos en dominios para elegir muestras de datos que:

- Representar casos de uso clave

- Incluya las condiciones de los bordes (p. ej., oclusiones, variaciones de iluminación)

- Excluir datos irrelevantes o redundantes

Evite que los datos se rastreen a ciegas desde Internet. Puede que sea grande, pero con frecuencia es inútil.

🎯 Anota con un propósito

Las anotaciones de calidad significan:

- Pautas de etiquetado claras

- Varios revisores o bucles de control de calidad

- Céntrese en los casos extremos y los límites de las decisiones

No se limite a anotar todo, anote el derecha cosas.

📉 Equilibra tus clases

En conjuntos de datos pequeños, el desequilibrio de clases puede destruir el rendimiento. Utilice técnicas como:

- Sobremuestreo selectivo de clases raras

- Datos sintéticos para categorías minoritarias

- Filtrado inteligente para eliminar los sesgos dominantes

🧠 Utilice el aprendizaje por transferencia, no el almacenamiento de datos

No siempre es necesario entrenar desde cero. Empieza con un modelo previamente entrenado (por ejemplo, YoloV8, ResNet, BERT) y ajústalo con tu conjunto de datos seleccionado.

Es como personalizar un traje de alta gama, adaptado a tu dominio.

Los pequeños datos en la era de los modelos básicos 🤖

Con el auge de modelos lingüísticos extensos (LLM) y modelos de cimentación multimodales, puede parecer que los datos pequeños se están volviendo irrelevantes. De hecho, lo contrario es cierto — los pequeños conjuntos de datos son ahora más valioso que nunca.

Así es como están remodelando la pila de IA moderna:

🧩 Ajuste fino para casos de uso hiperespecíficos

Los modelos fundamentales como GPT-4, Gemini y Claude están preentrenados en vastos corpus, pero son no está optimizado para tareas específicas fuera de la caja.

Las organizaciones ahora usan conjuntos de datos pequeños y de alta calidad para ajustar los modelos para:

- Resumen médico (p. ej., informes radiológicos)

- Clasificación de cláusulas legales

- Redacción de documentos basada en el cumplimiento

- Normalización del catálogo de productos minoristas

- Extracción del sentimiento financiero

Estas tareas sufrirían alucinaciones o desviaciones si se abordaran únicamente con instrucciones generales de LLM. Pero con incluso unos pocos miles de muestras seleccionadas, los modelos ajustados con precisión logran aumentos de rendimiento notables.

📘 Referencia: Guía de ajuste de OpenAI

🔐 Barandas, seguridad y equipo rojo

Los LLM son poderosos pero arriesgados. Los conjuntos de datos pequeños se utilizan cada vez más para entrenar restricciones de comportamiento, filtros o «barandillas» para prevenir:

- Lenguaje tóxico o sesgado

- Filtraciones de privacidad (por ejemplo, generar nombres reales a partir de datos de entrenamiento)

- Incumplimiento de la normativa en materia financiera, sanitaria, etc.

Empresas como Anthropic y Cohere utilizan pequeños conjuntos de datos específicos para pruebas de confrontación y alineación. No se trata de un reentrenamiento masivo, sino de una instrucción enfocada.

🔍 Evaluación y auditoría de modelos

No puedes confiar en lo que no puedes probar. Es por eso que pequeños conjuntos de datos seleccionados por expertos en dominios y equipos de control de calidad son esenciales para:

- Evaluación comparativa del rendimiento en casos extremos

- Predisposición de la superficie, deriva o modela puntos ciegos

- Creación de métricas de comportamiento de modelos explicables

A diferencia de los conjuntos de validación masivos, estos «conjuntos dorados» ofrecen transparencia, control y trazabilidad, algo clave para industrias como la banca, la defensa o la salud.

🧠 Sistemas Human-in-the-Loop

Los modelos integrados en los flujos de trabajo en vivo (por ejemplo, la suscripción, la atención al cliente y el diagnóstico) dependen cada vez más de conjuntos de datos pequeños y actualizados continuamente etiquetado por humanos durante la operación del modelo.

Estos bucles de retroalimentación entrenan minimodelos o adaptadores que especializan el modelo base a lo largo del tiempo, lo que mejora el rendimiento sin volver a entrenar todo el sistema.

Así es como la personalización ajustada funciona en tiempo real, desde chatbots hasta sistemas de recomendación y asistentes inteligentes.

De la cantidad de datos a la cultura de datos 🧭

La transición de «más es mejor» a «más inteligente es mejor» requiere un cambio de mentalidad en todo el equipo:

- Equipos de productos debe definir el conjunto de datos mínimo viable para lanzar una función de IA confiable

- Científicos de datos debe priorizar la capacidad de prueba y el análisis de errores por encima del tamaño

- Vendedores de etiquetado debe evaluarse en función de los flujos de trabajo de control de calidad, no solo del rendimiento

- Partes interesadas deben saber que 10 000 etiquetas limpias pueden superar a un millón de etiquetas sucias

Creación de una cultura de datos centrada en precisión, no Scale AI, es una ventaja competitiva.

Reflexiones finales: Por qué el futuro es preciso, no solo grande

Los macrodatos nos han traído hasta aquí. Pero no nos llevará allí.

Las historias de éxito de la IA actuales, desde la detección de defectos en tiempo real hasta la monitorización del clima y la medicina personalizada, no se basan en avalanchas de datos, sino en intención de datos. Los conjuntos de datos pequeños, seleccionados y ricos en contexto son más rápido de desarrollar, más barato de anotar, más fácil de validar y, en última instancia, más eficaz.

Si sigue persiguiendo la Scale AI sin claridad, es probable que esté desperdiciando recursos.

✨ En su lugar: concentre sus datos. Límpielo. Cúralo. Y observa cómo tu modelo supera a los gigantes.

Hagamos que sus datos sean más inteligentes, juntos 💡

¿Se siente abrumado por el exceso de datos y la falta de información? ¿O tiene problemas con una IA de bajo rendimiento a pesar de tener «suficientes» datos?

Ayudamos a equipos como el suyo a seleccionar Conjuntos de datos limpios, limpios y de alto rendimiento que realmente mueven la aguja. Ya sea que se dedique al cuidado de la salud, la venta minorista, la fabricación o el desarrollo de inteligencia artificial, lo respaldamos.

👉 Hablemos sobre la creación de su próximo conjunto de datos de alto impacto — de forma inteligente.

Póngase en contacto con nosotros ahora o explore nuestros estudios de casos reales para ver la diferencia que marca la precisión.

📬 ¿Tienes preguntas o proyectos en mente? DataVLab