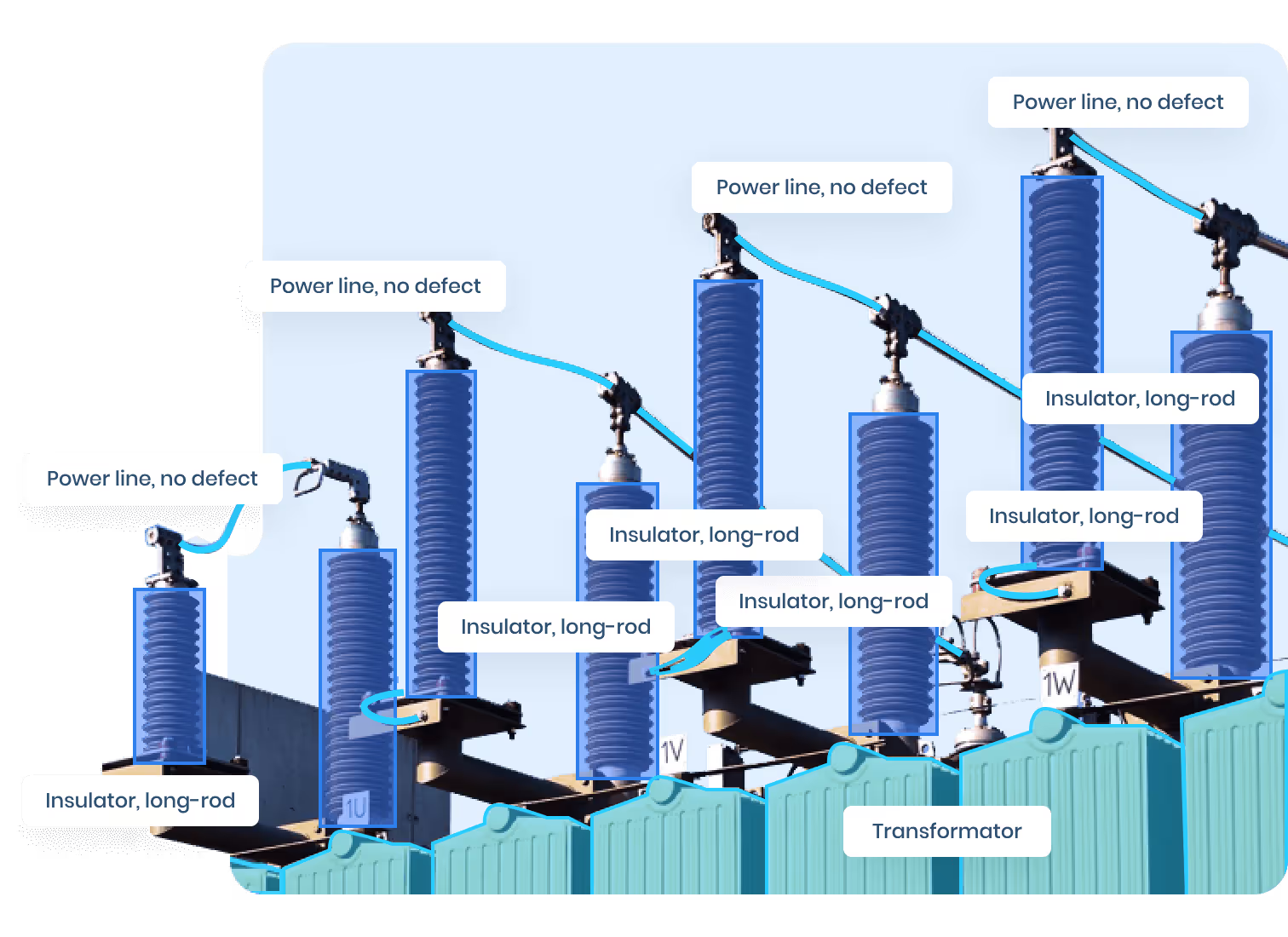

El verdadero valor de la anotación en la cámara del salpicadero en la conducción autónoma

La anotación con cámara de control no es solo un proceso técnico, es un facilitador estratégico para una conducción autónoma segura y confiable. A medida que la industria automotriz avanza hacia niveles más altos de autonomía, crece exponencialmente la necesidad de modelos de percepción que puedan hacer frente a la naturaleza impredecible de las carreteras del mundo real. Y nada proporciona mejor ese nivel de diversidad impredecible que las imágenes de una cámara de control.

Por qué las dashcams tienen un valor incalculable para la formación audiovisual

A diferencia de los conjuntos de datos recopilados con fines específicos en entornos cerrados, Los datos de la cámara del tablero ofrecen un realismo sin igual. Es lo que ven y experimentan los verdaderos conductores: tráfico de un extremo a otro, fusiones abruptas de carriles, peatones imprudentes, intersecciones cubiertas por la lluvia e incluso señales de construcción al borde de las carreteras escritas en dialectos regionales.

Esa variabilidad es una mina de oro para entrenar sistemas de percepción robustos. He aquí por qué:

- Diversidad ambiental: Las imágenes de la cámara del salpicadero capturan de forma natural una amplia gama de condiciones: carreteras soleadas, calles urbanas abarrotadas, mañanas con niebla y túneles con poca luz. Esta variedad ambiental ayuda a los modelos a generalizar mucho mejor que los datos sintéticos o seleccionados en laboratorio.

- Amplitud geográfica: Los automóviles equipados con cámaras de salpicadero graban en diversos países, culturas e infraestructuras viales, lo que proporciona información esencial para los despliegues audiovisuales globales. Desde las rotondas parisinas hasta las carreteras secundarias rurales de Texas, cada clip entrena al modelo para que reconozca los patrones específicos del contexto.

- Rareza del evento: Muchos eventos críticos para la seguridad (por ejemplo, un niño que cruza la calle corriendo o un vehículo que frena repentinamente) ocurren con muy poca frecuencia como para organizarlos o recogerlos manualmente. Sin embargo, las grabaciones de las cámaras del salpicadero, especialmente las recopiladas durante años conduciendo, capturan accidentalmente estas raras pero esenciales fundas periféricas.

- Señales de comportamiento: Las imágenes de la cámara del salpicadero capturan más que objetos; revelan cómo se comportan los actores de la carretera. Un peatón que duda antes de cruzar, un conductor que entra poco a poco en una intersección o un ciclista que se desvía inesperadamente: estos comportamientos sutiles son vitales para capacitar a los vehículos autónomos en la toma de decisiones predictivas.

- Bajo costo de configuración: En comparación con el LiDAR o los equipos de sensores de alta calidad, las dashcams son baratas, omnipresentes y siempre graban. Esto las convierte en una de las las fuentes más Scale AIbles de datos de conducción, especialmente para empresas emergentes o proveedores de primer nivel que crean conjuntos de datos internacionales.

Anotación de cámara de control del mundo real = AV más seguros e inteligentes

Cuando se enriquecen con anotaciones contextuales precisas, los datos de la cámara del tablero se convierten en un conjunto de datos estratégico que:

- Mejora la percepción AV en entornos no controlados (p. ej., intersecciones atípicas, infraestructura dañada, comportamiento humano complejo)

- Alimenta plataformas de simulación con escenas auténticas para poner a prueba los algoritmos

- Mejora los módulos de predicción de comportamiento, lo que permite a los vehículos autónomos anticipar mejor lo que otros usuarios de la carretera podrían hacer a continuación

- Valida las decisiones en tiempo real, especialmente en zonas geográficas con muchos casos extremos, como India, México o el sudeste asiático

Para los proveedores de primer nivel que desarrollan pilas de hardware y software para fabricantes de equipos originales, las imágenes anotadas de las cámaras de control no solo son útiles:es un diferenciador competitivo. Quienes dominen la diversidad, la calidad y la riqueza contextual de los datos impulsarán la próxima generación de vehículos verdaderamente autónomos.

El cliente: un proveedor de primer nivel con la misión de lograr carreteras más seguras

Nuestro cliente, un proveedor mundial de primer nivel que trabaja con varios de los principales fabricantes de automóviles, necesitaba datos anotados de su cámara de control para respaldar el desarrollo de sus módulo de percepción de próxima generación. Sus sistemas están integrados en ambos Plataformas ADAS y pilas totalmente autónomas.

Su equipo interno de I+D había acumulado terabytes de imágenes de cámaras de control de varios países, pero carecía de la capacidad y la infraestructura para realizar anotaciones a gran Scale AI.

Se acercaron a nosotros para abordar:

- Etiquetado de alta precisión de objetos, carriles y señales de tráfico

- Seguimiento basado en secuencias para capturar el movimiento a través de fotogramas

- Etiquetado contextual de escenarios de conducción desafiantes (por ejemplo, deslumbramiento, nieve, conducción nocturna)

- Identificación de carcasas periféricas para eventos poco frecuentes o riesgosos (p. ej., peatones que cruzan imprudentemente, vehículos parados)

Desafíos clave a la hora de anotar imágenes de cámara de control

La anotación con cámara de control es fundamentalmente diferente a la anotación de vídeos seleccionados con calidad de laboratorio. He aquí por qué este proyecto requería soluciones a medida:

1. Artefacto de compresión y desenfoque de movimiento

Las dashcams suelen grabar a 30 FPS con una compresión agresiva. Los marcos pueden estar borrosos o distorsionados, lo que hace que los bordes de los objetos sean menos definidos y más difíciles de etiquetar.

🧩 Solución: Desarrollamos un proceso de validación de marcos para detectar y eliminar fotogramas inutilizables, preservando la calidad de los datos sin perder tiempo de anotación.

2. Condiciones climáticas y de iluminación impredecibles

Desde la luz solar directa hasta las mañanas con niebla y los parabrisas salpicados por la lluvia, los cambios de iluminación afectan la visibilidad y la apariencia de los objetos.

🧩 Solución: Los anotadores recibieron directrices específicas para cada escenario (por ejemplo, cómo gestionar las reflexiones al anochecer) y la revisión de las anotaciones se dividió por tipo de condición para mantener la coherencia.

3. Objetos obstruidos u ocluidos

Los peatones parcialmente ocultos por los automóviles estacionados o los ciclistas que se mueven entre los vehículos son comunes y fundamentales para las aplicaciones de seguridad.

🧩 Solución: Integramos un enfoque centrado en el seguimiento, donde el contexto temporal ayudó a eliminar la ambigüedad de los objetos parcialmente visibles.

4. Etiquetado de secuencias de vídeo extendidas

La anotación en clips de vídeo largos provoca fatiga y deriva en las etiquetas. Sin coherencia temporal, los identificadores de seguimiento y la coherencia de los objetos se desmoronan.

🧩 Solución: Usamos herramientas semiautomatizadas de interpolación y propagación de ID, lo que acelera considerablemente el seguimiento constante de los objetos y, al mismo tiempo, mantiene la supervisión humana.

Flujos de trabajo personalizados para una canalización de anotaciones exigente

El proyecto no consistía en ejecutar una herramienta de anotación genérica, sino en crear una motor de datos a medida. Introdujimos varios flujos de trabajo clave para satisfacer las necesidades cambiantes del cliente:

Seguimiento de objetos de alta fidelidad

A cada instancia (peatón, automóvil, motocicleta, semáforo) se le asignó un ID persistente en todos los marcos, con notas detalladas sobre la entrada y la salida del campo de visión.

En particular, objetos dinámicos (autobuses, scooters, vehículos de emergencia) requieren:

- Evolución precisa de la caja delimitadora a lo largo del tiempo

- Estimación de vectores de velocidad y movimiento

- Clasificación por patrón de movimiento (p. ej., fusión, parada, comportamiento errático)

Marcación adaptativa de carriles

Las anotaciones de carril eran especialmente complicadas. Con marcas viales variadas, poca visibilidad y zonas en construcción, no podíamos basarnos en suposiciones estáticas.

Trabajamos con el cliente para desarrollar clases de carril personalizadas basado en:

- Tipo (sólido, discontinuo, doble)

- Nivel de visibilidad (claro, parcial, desgastado)

- Caso de uso (carril para bicicletas, carril para girar, carril para autobuses)

Esto ayudó a sus modelos no solo a detectar carriles, sino también a comprender su función.

Etiquetado de escenarios y capa de metadatos

Más allá de las etiquetas de objetos, agregamos superposiciones de metadatos describir cada contexto de conducción. Los ejemplos incluyen:

- «Lluvia fuerte»

- «Túnel con poca iluminación»

- «Intersección con semáforos ocluidos»

- «Un peatón entra entre los coches estacionados»

Estas etiquetas fueron cruciales para crear conjuntos de datos límite y para la evaluación de modelos específicos.

Control de calidad: garantizar la coherencia en más de 1 millón de fotogramas

Al trabajar con volúmenes masivos de datos secuenciales, la consistencia es la reina. Una etiqueta incorrecta puede degradar el rendimiento del modelo. Así es como mantuvimos la calidad en todo momento:

Sistema de revisión de varios niveles

Implementamos un Revisión de 3 niveles:

- Revisión inicial por un anotador de pares con formación específica para cada escenario

- Control de calidad por lotes por un anotador sénior que revisa tanto la calidad de las etiquetas como la coherencia de la secuencia

- Auditorías puntuales por el equipo de validación interno del cliente utilizando nuestros informes

Detección de deriva de etiquetas temporales

Los scripts personalizados detectaron la desviación de las etiquetas a lo largo del tiempo, marcando:

- Desaparición repentina de objetos

- Anomalías en el tamaño de los recuadros delimitadores

- Reasignación de ID incorrecta entre oclusiones

Esto nos permite detectar pronto las inconsistencias sutiles.

Paneles de control de calidad visual

Para ayudar tanto a nuestro equipo como al cliente a monitorear el progreso y la calidad, implementamos paneles interactivos mostrando:

- Distribución de clases en todo el conjunto de datos

- Ejemplos de marcos por etiqueta

- Revisa las estadísticas del ciclo

- Mapas térmicos de velocidad de anotación frente a tasa de error

Qué hizo que este proyecto fuera único (y un éxito) 🚀

Varios factores ayudaron a este proyecto a superar las expectativas:

- Colaboración estrecha con los clientes: Las sincronizaciones semanales garantizaron una retroalimentación rápida y la incorporación de prioridades cambiantes en tiempo real.

- Anotación a Scale AI: Nos encargamos 10 000 secuencias y anotó más de 1 millón de fotogramas en menos de 4 meses.

- Diseño preparado para el futuro: Nuestro canal de entrega de datos se creó para integrarse directamente en la pila de MLOps del cliente.

Gracias a este proyecto, el cliente ahora:

✅ Tiene una biblioteca seleccionada de casos extremos desafiantes

✅ Puede simular escenarios poco comunes para probar modelos AV

✅ Introduce secuencias del mundo real en su módulo de predicción de comportamiento

Los modelos entrenados en este conjunto de datos mostraron mejora significativa de MaP en todos los ámbitos, especialmente para clases como motocicletas y peatones parcialmente ocluidos.

Lecciones aprendidas: la anotación no es solo una tarea, es una asociación

A medida que se desarrollaba el proyecto, se hizo cada vez más claro: una anotación exitosa a esta Scale AI se basa menos en marcar casillas y más en la alineación continua entre anotadores humanos, ingenieros de aprendizaje automático y expertos en el dominio.

Estas son las ideas más valiosas que aprendimos del viaje:

1. La anotación no es única para todos

Las imágenes de la cámara del salpicadero varían enormemente. Incluso dentro de la misma ciudad, un viaje soleado al trabajo por la mañana no se parece en nada a una hora punta por la tarde lluviosa. Una pauta estática no puede cubrir todos los matices. Las instrucciones de anotación deben evolucionar con el metraje—especialmente cuando se trata de deslumbramientos, oclusiones, zonas de construcción o cambios en el ángulo de la cámara.

Para llevar: Mantenga dinámicos los protocolos de anotación. Ejecute lotes piloto y adapte las reglas basándose en casos extremos reales, no en ejemplos teóricos.

2. La experiencia humana aún supera a la automatización total

A pesar del auge de las herramientas de automatización y los algoritmos de interpolación, el juicio humano era insustituible, especialmente en:

- Intento de interpretación (por ejemplo, ¿el peatón está a punto de cruzar o simplemente está de pie?)

- Clasificación de objetos parcialmente ocluidos o ambiguos

- Manejar interacciones inusuales, como vehículos de emergencia que infringen las normas de tráfico

Descubrimos que Los flujos de trabajo semiautomatizados impulsados por la verificación humana lograron el equilibrio adecuado entre velocidad y precisión.

Para llevar: La automatización aumenta la Scale AI, pero los casos extremos del mundo real siguen exigiendo ojos humanos entrenados.

3. El pensamiento centrado en la percepción supera al pensamiento centrado en los píxeles

La anotación tradicional suele centrarse en los píxeles: dibujar la caja, la máscara o el polígono perfectos. Pero a la hora de entrenar modelos de percepción audiovisual, la comprensión contextual es más importante. Por ejemplo:

- Es posible que un objeto borroso siga siendo identificable en función de su trayectoria de movimiento en los fotogramas anteriores.

- Las marcas de carril que desaparecen bajo el resplandor deben seguir anotándose si el contexto de la carretera sugiere continuidad.

Entrenando a los anotadores para piensa como los ingenieros de percepción, creamos un conjunto de datos que era más útil en el futuro, incluso si eso significaba desviarse a veces de la perfección de los píxeles.

Para llevar: Enseñe a los anotadores a pensar en términos de la lógica de percepción audiovisual, no solo de la precisión de la imagen.

4. Los circuitos de retroalimentación entre la anotación y el entrenamiento del modelo son fundamentales

Los desarrolladores de modelos suelen trabajar de forma aislada de los equipos de anotación. Sin embargo, en este proyecto, los ciclos de retroalimentación son frecuentes (por ejemplo, «Nuestro modelo tiene problemas con estas zonas de construcción, ¿podemos etiquetarlas mejor?») nos ayudó optimizar el conjunto de datos específicamente para el rendimiento del modelo en el mundo real.

Este ciclo permitió mejoras proactivas como:

- Crear una etiqueta independiente para los «carriles temporales»

- Ajustar la estanqueidad del cuadro delimitador en objetos de alta velocidad

- Agregar marcadores de eventos para resaltar el comportamiento anormal

Para llevar: La anotación no debe estar «entregada y lista». Cierre el círculo con los equipos modelo desde el principio y con frecuencia.

5. La curación de Edge Case es la verdadera salsa secreta

Si bien etiquetar más de 1 millón de marcos es impresionante, lo que realmente generó valor fue nuestra capacidad de muestra y etiqueta escenarios poco comunes y de alto riesgo:

- Peatones distraídos con auriculares que se caen de las aceras

- Conductores que ignoran las señales de stop

- Ciclistas que se desvían debido a baches

Estas raras fundas no solo hacen que el AV sea más inteligente, sino que lo hacen más seguro.

Para llevar: No trate los casos extremos como ruido estadístico. Trátelos como oro de entrenamiento.

6. La calidad de las anotaciones mejora con Annotator Empowerment

Cuando se trata a los anotadores como si fueran mano de obra dentada, la calidad se ve afectada. Pero cuando entienden el «por qué» detrás de la tarea (qué hará el modelo con los datos), invierten más y son más precisos.

Hemos empoderado a los anotadores con:

- Acceso a los comentarios sobre los modelos en tiempo real

- Explicaciones claras del impacto del proyecto

- Oportunidades para señalar casos extremos o proponer cambios en el protocolo

Para llevar: Invierta en la comprensión y la participación de los anotadores. Su perspicacia es su ventaja invisible.

7. La colaboración con los clientes impulsa el éxito a largo plazo

Las sincronizaciones semanales con el proveedor de primer nivel no solo tenían que ver con actualizaciones, sino que permitían:

- Comentarios en tiempo real sobre la evolución de los casos extremos

- Resolución conjunta de problemas (por ejemplo, cómo tratar los reflejos de luz en carreteras mojadas)

- Alineación con respecto al uso posterior del conjunto de datos

La colaboración fomentó confianza, agilidad y propiedad compartida, todo lo cual contribuyó al éxito duradero del proyecto.

Para llevar: Trate al cliente como un socio de producto, no solo como un comprador.

Al final del proyecto, no solo entregábamos vídeos con anotaciones, sino que también entregábamos una base de datos capaz de impulsar la seguridad audiovisual en entornos complejos del mundo real.

Cuando la anotación se alinea con la percepción, se enriquece con el contexto y se apoya en comentarios colaborativos, pasa de ser un centro de costos a un pilar estratégico del desarrollo autónomo.

¿Tienes curiosidad por saber cómo Dashcam Annotation puede subir de nivel tu pila AV? 👇

Si tu equipo está viendo horas (o terabytes) grabando imágenes de cámaras de control o sensores y se pregunta cómo prepararlas para el modelo:no estás solo.

En DataVlab, hemos ayudado a los proveedores de primer nivel, a las empresas emergentes de AV y a los fabricantes de equipos originales a anotar todo, desde los cambios de carril hasta los peatones que cruzan imprudentemente en el tráfico del mundo real.

Hablemos—ya sea que esté planificando su primer conjunto de datos o ampliándolo a millones de marcos, nos encantaría colaborar.

🔗 DataVLab

📩 O comunícate directamente para iniciar la conversación.