El auge de la IA multimodal

La IA ya no está ciega al contexto. Si bien los primeros modelos solo podían analizar entradas aisladas (solo texto, solo imágenes o solo audio), las arquitecturas más nuevas, como CLIP de OpenAI y Flamingo de Google, están superando los límites al interpretar y conectar múltiples modalidades de datos a la vez.

La IA multimodal imita la forma en que los humanos perciben el mundo. Piensa en una videollamada: escuchas el tono de una persona, lees sus expresiones faciales y entiendes el contexto en función de sus palabras. Entrenar a la IA para que haga lo mismo requiere un conjunto de datos rico y estructurado con datos precisos y anotaciones multimodales.

🧠 «El futuro de la IA no se basa en un sentido, sino en la sinergia».

Por qué es importante la anotación multimodal

En un mundo repleto de sensores de vídeo, redes sociales e IoT, los datos del mundo real son intrínsecamente multimodales. Para entrenar sistemas inteligentes, la anotación de datos debe reflejar esta diversidad.

La anotación multimodal permite a la IA:

- Comprenda los matices emocionales de la voz y las expresiones faciales.

- Vincula las palabras habladas con el contexto visual en las transmisiones de vídeo.

- Extraiga y correlacione la información de los documentos con texto e imágenes.

- Genere respuestas más precisas y fluidas en agentes conversacionales multimodales.

No se trata solo de etiquetar; se trata de enseñar a las máquinas a razonar en todas las modalidades.

Casos de uso que se basan en el etiquetado multimodal

Exploremos cómo la anotación multimodal impulsa los sistemas de IA del mundo real en todos los sectores:

🎥 Moderación de contenido de vídeo

YouTube, TikTok y Facebook utilizan la IA para marcar contenido inapropiado. Sin embargo, la moderación del contenido no puede basarse en una sola señal. Una frase hablada, una señal visual o unos subtítulos incrustados pueden contener un contexto importante. Etiquetar las transcripciones de audio, las expresiones faciales y las secuencias de fotogramas permite a los modelos de moderación entender a la vez las violaciones del tono, el sarcasmo y la imagen.

🧾 Inteligencia documental

Los seguros, la banca y la atención médica a menudo se basan en formularios con texto e imágenes escaneadas. La anotación multimodal es esencial para alinear el texto del OCR con el diseño, las estructuras de las tablas y los elementos visuales incrustados (como gráficos o notas manuscritas). Esto permite que modelos como DocAI de Google extraigan datos estructurados con precisión.

🧑 🏫 Asistentes virtuales de aprendizaje

Las plataformas de tutoría inteligentes como Duolingo o Khan Academy están empezando a incluir pronunciación en audio, instrucciones de texto y ayudas visuales. Al anotar los patrones del habla, los gestos visuales y las explicaciones textuales, estos agentes pueden responder de forma natural y contextual, como lo haría un verdadero tutor.

🚗 Vehículos autónomos

Los vehículos autónomos integran datos de LiDAR, cámaras, radares y audio (por ejemplo, bocinazos, sirenas). La anotación de fotogramas de vídeo, la transcripción de eventos de sonido y objetos espaciales a lo largo del tiempo permite a los modelos comprender entornos complejos.

🧍 ♂️ Interacción entre humanos e IA

Los asistentes como Siri, Alexa y el Asistente de Google dependen del entrenamiento multimodal para alinear la intención de la voz, las acciones en pantalla y el contexto visual. Cuando un usuario dice: «¿Qué es esto?» mientras señala algo en la pantalla de un teléfono, el modelo debe conectar el enunciado (audio), el contenido de la pantalla (visual) y la interacción (gesto/texto) para responder de forma inteligente.

¿Qué hace que la anotación multimodal sea tan desafiante?

El valor de los datos multimodales es enorme, pero también lo es su complejidad. Analicemos algunos de los mayores desafíos:

Alineación temporal

La sincronización de eventos a lo largo del tiempo suele ser complicada. Por ejemplo, hacer coincidir un enunciado con una expresión facial en un vídeo cuadro por cuadro exige códigos de tiempo y granularidad precisos.

Ambigüedad intermodal

¿Qué ocurre cuando la imagen y el audio entran en conflicto? Supongamos que un usuario sonríe visualmente pero dice algo sarcástico. Los anotadores deben decidir qué señal tiene más peso, y los modelos de IA necesitan metadatos para gestionar esas contradicciones.

Volumen y costo

Los conjuntos de datos multimodales son grandes por naturaleza. Un solo segundo de vídeo puede contener:

- Decenas de marcos de imágenes,

- Subtítulos o texto transcrito,

- Múltiples canales de audio.

Etiquetar todo esto con precisión es caro. Los anotadores humanos deben tener una formación específica, y las interfaces de etiquetado deben admitir la ingestión de datos multimodales y el etiquetado teniendo en cuenta el contexto.

Coherencia de las anotaciones

Mantener la coherencia entre los anotadores y las modalidades requiere directrices claras y flujos de trabajo de control de calidad sólidos. Es habitual definir funciones de control de calidad especializadas por modalidad (por ejemplo, lingüistas para el audio y expertos médicos para la imagen).

Creación de un flujo de trabajo de anotación multimodal que funcione

Para poder etiquetar imágenes, texto y audio de forma conjunta, su flujo de trabajo debe tener en cuenta la interjugar entre estas entradas, no solo trátelas como silos.

Así es como los equipos avanzados diseñan sus canalizaciones multimodales:

1. Fusión de datos antes del etiquetado

En lugar de anotar cada modalidad por separado y fusionarla más adelante (lo que corre el riesgo de desalinearse), los equipos inteligentes combinar datos en la fase de ingestión. Esto a menudo implica:

- Alineación de marca de tiempo

- Mapeo entre fotogramas y transcripciones

- Preprocesamiento para que coincida con la resolución y el formato

Esto garantiza que los anotadores vean el contexto completo antes de etiquetar.

2. Interfaces sensibles al contexto

Las herramientas de anotación deben mostrar las formas de onda de audio junto con las transcripciones y los datos visuales. Bibliotecas de código abierto como Cincuenta y uno o Prodigio permiten la integración de múltiples modalidades en una visión unificada.

3. Especialización en directrices

Evite las instrucciones genéricas. Proporcione normas específicas de modalidad con ejemplos claros de casos extremos:

- ¿Cuándo se debe marcar el ruido de fondo?

- ¿Deberían segmentarse los discursos superpuestos?

- ¿Cómo tratar la oclusión parcial en vídeo?

4. Armonización de la taxonomía de etiquetas

Incluso si las etiquetas de audio y las etiquetas de imagen son distintas, deben seguir una lógica compartida para que puedan agregarse más adelante. Usa definiciones de clases unificadas para reducir la ambigüedad posterior.

5. Control de calidad humano al día

Confiar completamente en la automatización es peligroso. Los ámbitos de alto riesgo (como la atención de la salud o las finanzas) se benefician si los revisores expertos validan la coherencia multimodal antes de impartir el modelo de formación.

Estrategias de anotación en todas las modalidades

La anotación multimodal no consiste solo en etiquetar tres modalidades distintas, sino en unirlas de manera significativa. El verdadero valor reside en la forma en que las etiquetas interactúan entre los formatos para reflejar la comprensión del mundo real. Ya sea que estés creando un modelo de recuperación, una herramienta de tecnología de asistencia o un sistema autónomo, las estrategias intermodales inteligentes te permiten entrenar a la IA para que piense más como un ser humano.

Analicemos las estrategias de anotación eficaces en las combinaciones de modalidades (y tríadas) más comunes:

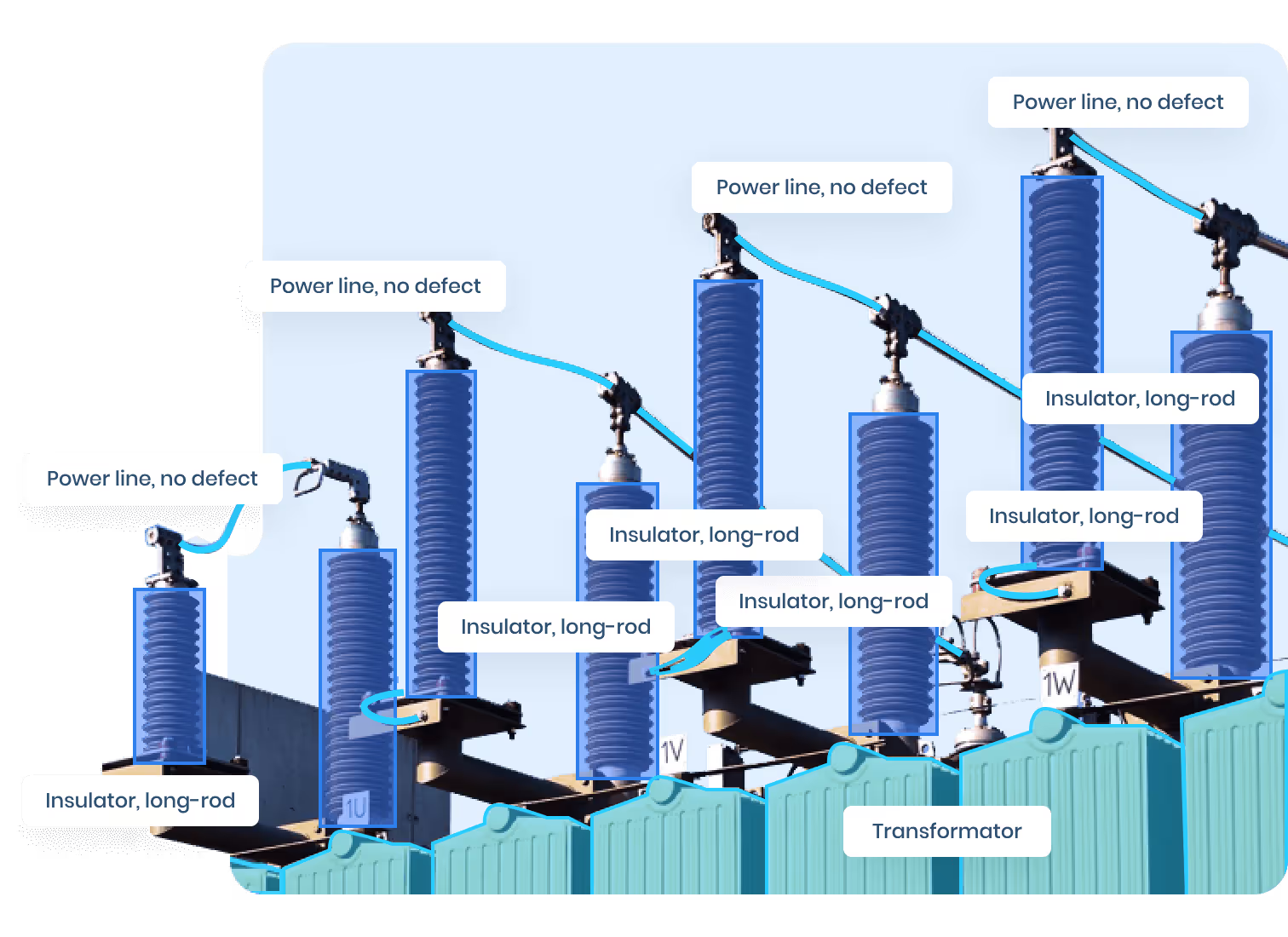

📸 Imagen + texto

Esta es una de las combinaciones multimodales más comunes en la IA, que se utiliza con frecuencia en:

- Respuesta visual a preguntas (VQA)

- Generación de descripciones de productos

- Herramientas de subtitulado y accesibilidad

- Fundamentar el lenguaje en la entrada visual

Las mejores estrategias de anotación:

- Utilice la alineación a nivel de región: etiquete áreas específicas de la imagen (recuadros o segmentos delimitadores) y vincúlelas a las frases correspondientes de un título, una descripción o una pregunta.

- Etiquete el sentimiento de la imagen y el estado de ánimo visual para combinarlos con el tono emocional del texto (especialmente útil en marketing y análisis de medios).

- Si el texto está superpuesto (como en memes o anuncios), anótelo por separado del subtítulo mediante una estrategia de OCR de doble capa.

Ejemplo de caso de uso: En el comercio electrónico, etiquete las imágenes de moda con atributos descriptivos («chaqueta vaquera azul, mangas enrolladas») y etiquete las reseñas de texto que hagan referencia a esos atributos. Esto permite a un modelo basar la confianza del comprador con características visuales.

🎧 Audio + Texto

Utilizado en aplicaciones como la transcripción, la detección de emociones, los asistentes de voz y el reconocimiento de voz, este par exige una alta precisión temporal y profundidad semántica.

Las mejores estrategias de anotación:

- Alinee en el tiempo los fragmentos de transcripción con los segmentos de audio correspondientes mediante herramientas de alineación forzada como Gentil o Alineador forzado de Montreal.

- Agregue capas de metadatos como:

- ID del altavoz

- Niveles de ruido de fondo

- Sentimiento o intención

- Disfluencias en el habla (p. ej., palabras de relleno, vacilaciones)

- Anota las interrupciones, las superposiciones y la toma de turnos en los diálogos para modelar la conversación.

Ejemplo de caso de uso: En el caso de una IA del servicio de atención al cliente, etiquete cada enunciado con la identidad del hablante, la emoción (frustrado, neutral, útil) y la intención («solicitar un reembolso», «hacer una pregunta») para que el modelo pueda aprender los patrones de Scale AImiento y las respuestas adecuadas.

🎥 Audio + Imagen (y vídeo)

Esta combinación es esencial en tareas multimedia como la vigilancia, el análisis del comportamiento, la inteligencia artificial de entretenimiento y los sistemas autónomos. A diferencia del texto, las señales de audio y visuales deben ser sincronizado en el tiempo, lo que hace que la anotación sea exigente desde el punto de vista técnico y cognitivo.

Las mejores estrategias de anotación:

- Anota las fuentes de sonido espacialmente; por ejemplo, identifica de dónde proviene el sonido de la bocina de un automóvil en el marco.

- Marque los eventos de movimiento y combínelos con los eventos de audio (por ejemplo, «rotura de vidrios» + «sonido que se rompe»).

- Usa la segmentación basada en escenas: divide los vídeos en escenas discretas, cada una con su propio conjunto de etiquetas audiovisuales.

Ejemplo de caso de uso: En la IA deportiva, combina el sonido de un silbato con el movimiento del jugador y los gestos del árbitro para anotar los paros o las faltas.

🧠 Trimodal: imagen + texto + audio

Aquí es donde surge la verdadera inteligencia multimodal, como en los vídeos educativos, las herramientas de aprendizaje de idiomas o los avatares emocionalmente inteligentes.

Las mejores estrategias de anotación:

- Utilice anotaciones jerárquicas: comience con etiquetas específicas de la modalidad y, a continuación, defina las relaciones intermodales (por ejemplo, «el orador hace referencia al objeto en la marca de tiempo X»).

- Introduce anotaciones de «nivel narrativo» que cubran el significado más allá de la suma de las partes (por ejemplo, «explicación de la fotosíntesis» abarca 25 segundos de vídeo con diagrama, voz y subtítulo).

- Mantenga la coherencia: etiquete la misma entidad en todas las modalidades con un identificador único para facilitar el seguimiento de objetos o la comprensión referencial.

Ejemplo de caso de uso: En el caso de la IA de accesibilidad, anota un video tutorial vinculando la explicación oral, las imágenes en pantalla y los subtítulos para garantizar que los formatos alternativos (por ejemplo, audiodescripción o lectores de pantalla) puedan reconstruir la experiencia de aprendizaje completa.

Entrenamiento de la IA con multimodal Ground Truth

Una vez que haya etiquetado su conjunto de datos multimodal, comienza la verdadera magia: convertir las anotaciones en acciones señales de entrenamiento para tus modelos de IA.

Sin embargo, entrenar la IA multimodal no es tan sencillo como alimentar todos los datos a la vez. Requiere diseñar arquitecturas que puedan alinear, comparar y razonar en todas las modalidades, y estructurar los datos en consecuencia.

A continuación, te explicamos cómo sacar el máximo provecho de tus anotaciones:

Enseñe a los modelos a «alinear» las modalidades

La alineación es el principio fundamental de la IA multimodal. Una modelo debe entender que la frase «un perro saltando» coincide con un clip visual de un perro en el aire y un ladrido excitado en el audio.

Estrategias recomendadas:

- Utilice aprendizaje contrastivo (por ejemplo, como se usa en CLIP o ALIGN): muestre el modelo de pares positivos y negativos y enséñele a identificar qué modalidades corresponden.

- Estructura tus muestras de entrenamiento para incluir texto, imagen o audio de referencia, una muestra coincidente y muestras distractoras (no coincidentes).

- Añadir pérdida de entropía cruzada o pérdida de tripletes en función del grado de alineación de las incrustaciones.

Usa la atención cruzada para dejar que las modalidades hablen

Los transformadores multimodales como LXMERT, VisuAlbert o Flamingo utilizan mecanismos de atención cruzada, lo que permite al modelo sopesar la información de una modalidad al analizar otra.

Cómo estructurar la formación para ello:

- Segmenta tus entradas en tokens de modalidad (por ejemplo, tokens de texto, parches de imágenes, incrustaciones de audio).

- Aplica la autoatención dentro de cada modalidad y la atención cruzada entre ellas.

- Fomente el aprendizaje de la representación conjunta: permita que las cabezas compartidas o las capas fusionadas descubran una superposición semántica de alto nivel.

Esto es especialmente eficaz para tareas como la respuesta a preguntas en vídeo o el resumen multimodal.

Prediga en todas las modalidades

Los datos anotados se pueden usar para tareas de predicción enmascaradas o generativas:

- Enmascara una palabra y deja que el modelo la adivine usando señales de imagen/audio.

- Enmascare una región de la imagen y pida al modelo que la describa con el texto y el sonido asociados.

- Entrena al modelo para generar una modalidad basada en las demás (por ejemplo, generar subtítulos a partir de una entrada de audio o imagen).

Esto crea aprendizaje robusto de representación y permite la transferencia a tareas posteriores (como traducción, recuperación, etc.) con menos ejemplos etiquetados.

Entrene con insumos de modalidad mixta y de aumento

Utilice aumento de datos multimodal para impulsar la generalización:

- Elimine aleatoriamente una modalidad durante el entrenamiento para simular entradas ruidosas.

- Cambia el orden de las modalidades o intercambia segmentos similares (por ejemplo, sonidos o frases similares) para probar la generalización.

- Usa técnicas como MixModal—combinar funciones en todas las modalidades para la síntesis de datos.

💡 Ejemplo: un ejemplo de formación que incluya solo audio e imagen se puede seguir utilizando para enseñar la asociación semántica, incluso sin texto. Los modelos entrenados con modalidades faltantes funcionan mejor en condiciones de incertidumbre en el mundo real.

Evalúe con puntos de referencia intermodales

Su modelo no es verdaderamente «multimodal» a menos que funcione en diversos puntos de referencia. Estas son algunas de las que puedes probarlas:

- VQA: ¿Puede su modelo responder a las preguntas basadas en imágenes y texto?

- Conjunto de audio: ¿Puede etiquetar eventos sonoros y relacionarlos con escenas?

- NLVR2: ¿Entiende el lenguaje natural y el razonamiento visual?

- Cómo 100 m o Tú cocinas 2: ¿Puede analizar el vídeo instructivo en todas las modalidades?

Evalúe siempre no solo la precisión, sino sensibilidad a la modalidad—qué tan bien se adapta el modelo a señales parciales, ruidosas o ausentes.

Use sus etiquetas para ajustar los modelos de base

Los grandes modelos multimodales como GPT-4o, Gemini o LLava ya «entienden» muchas modalidades. Pero aún así se benefician de ajuste fino en conjuntos de datos anotados específicos de un dominio.

Sus anotaciones de alta calidad pueden ayudar a estos modelos:

- Especialízate en dominios médicos, legales o industriales

- Aprenda idiomas, acentos o estilos visuales locales

- Mejore la precisión en los casos extremos que los modelos generalizados pasan por alto

En lugar de entrenar desde cero, muchos equipos ahora afinar los modelos de base en conjuntos de datos multimodales pequeños y específicos para obtener el máximo ROI.

Al estructurar cuidadosamente sus anotaciones multimodales y su proceso de entrenamiento, no solo está creando un conjunto de datos, sino que está creando un ecosistema de comprensión que une el lenguaje, la visión y el sonido. Y ese es exactamente el tipo de inteligencia que exige el futuro de la IA.

Perspectivas del sector: ¿Quién utiliza la IA multimodal?

El uso de la anotación multimodal se está expandiendo rápidamente en todos los sectores:

- Asistencia sanitaria: Anotar imágenes radiológicas junto con notas clínicas y registros médico-paciente para la IA diagnóstica.

- Seguridad: Integración de imágenes de CCTV con transcripciones de sonido y texto para la detección de amenazas.

- Educación: Etiquetar las interacciones de voz, gestos y pantalla de los estudiantes para un aprendizaje adaptativo.

- Venta minorista: Comprender el comportamiento de los compradores mediante la combinación de imágenes de estanterías, consultas de voz y registros de compras.

Organizaciones como Meta AI, DeepMind y OpenAI están invirtiendo activamente en conjuntos de datos multimodales a gran Scale AI, pero incluso los equipos más pequeños pueden beneficiarse de empezar de a poco y Scale AIr de forma inteligente.

Consideraciones éticas en el etiquetado multimodal

La calidad de los datos conlleva una gran responsabilidad.

La anotación multimodal puede ser invasiva: piense en las grabaciones de voz, las expresiones faciales o el etiquetado de sentimientos emocionales. Asegúrese de que su canalización respete:

- Privacidad de datos y consentimiento, especialmente en aplicaciones médicas o de vigilancia.

- Auditorías de sesgo, en particular cuando las señales visuales o de voz puedan reflejar estereotipos culturales.

- Bienestar del anotador, ya que etiquetar los datos emocionales (por ejemplo, angustia, violencia) puede afectar la salud mental.

💡 Un recurso a tener en cuenta es Asociación sobre las mejores prácticas de la IA para el enriquecimiento de datos.

De cara al futuro: el futuro de la anotación multimodal

El futuro de la anotación multimodal está determinado por algunas tendencias poderosas:

- Generación de datos sintéticos: Herramientas como DALL·E o AudioLDM permiten simular muestras multimodales, lo que reduce el esfuerzo de etiquetado humano.

- Modelos de cimentación multimodales: Es posible que los modelos de ajuste fino como Gemini, GPT-4o o Flamingo pronto requieran nuevas formas de anotación dinámica basada en la interacción.

- Modelado temporal: Anotar no solo lo que hay en un marco, sino cómo cambia con el tiempo (por ejemplo, gestos, cambios de humor) impulsarán la interacción de la IA en tiempo real.

A medida que evolucionen las estrategias de anotación, espere más herramientas de etiquetado interactivas, mejor canales de aprendizaje activos, y un uso más amplio de crowdsourcing en todas las modalidades—pero siempre anclados en la claridad, la ética y el diseño inteligente.

💬 ¿Quiere datos de entrenamiento multimodal más inteligentes?

Si estás trabajando en proyectos de IA que necesitan hacer bien las anotaciones de imagen, texto y audio, no lo hagas solo. En DataVlab, nos especializamos en el etiquetado de datos multimodales de alta calidad y de origen ético para equipos de IA de vanguardia.

Ya sea que esté comenzando con unas pocas muestras piloto o ampliando su Scale AI a millones de registros multimodales, nuestros expertos pueden ayudarlo a:

- Cree flujos de trabajo de anotación personalizados

- Diseñar taxonomías transmodales

- Garantice la calidad y el cumplimiento desde el primer día

👉 Hablemos DataVLab para explorar cómo podemos adaptar una estrategia de anotación multimodal a sus necesidades de IA.

📌 Relacionado: Cómo anotar imágenes para modelos de IA de OCR y detección de texto